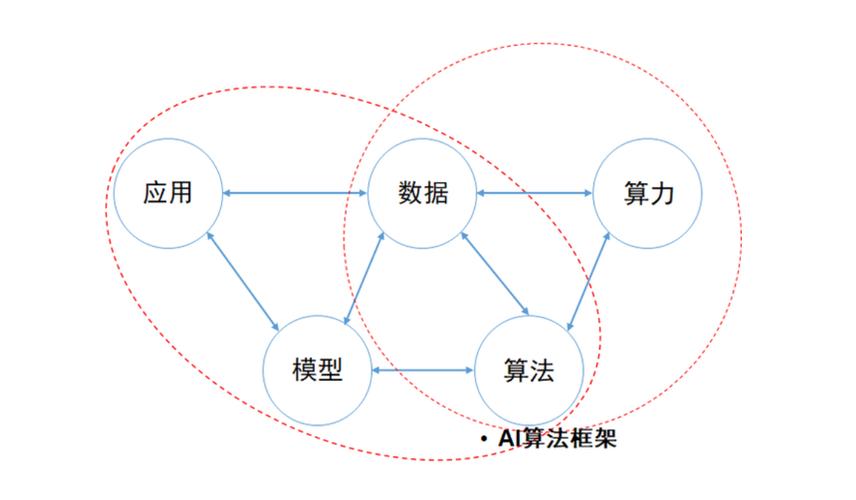

AI 训练框架与算法是人工智能领域中相互依存、协同作用的两个核心要素,二者的关系可以概括为:算法是 “核心逻辑”,框架是 “实现载体与运行基座”,具体可从以下几个层面理解:

1. 算法:AI 的 “思想与策略”,决定 “做什么、怎么做”

AI 算法是解决特定问题的数学逻辑、步骤和策略,是 AI 系统的 “灵魂”。它定义了如何从数据中学习规律、如何进行推理决策,例如:

深度学习中,CNN(卷积神经网络)是处理图像的算法(通过卷积操作提取空间特征);

RNN/LSTM 是处理序列数据(如文本、语音)的算法(通过循环结构捕捉时序依赖);

优化算法(如 SGD、Adam)是指导模型参数更新的策略(定义如何根据损失调整权重);

强化学习中的 Q-Learning、PPO 是智能体与环境交互并学习最优策略的算法。

算法的核心是 “逻辑设计”,不依赖具体工具,但需要通过工具落地。

2. 训练框架:AI 的 “工程工具集”,支撑 “算法实现与高效运行”

AI 训练框架(如 TensorFlow、PyTorch、MindSpore 等)是为算法实现和训练提供的底层工具集,它封装了复杂的工程细节(如硬件交互、并行计算、自动微分等),让开发者无需从零构建基础组件,专注于算法逻辑本身。其核心作用包括:

简化算法实现:提供高层 API(如 PyTorch 的nn.Module、TensorFlow 的Keras),封装常用算子(卷积、矩阵乘法、激活函数等),让开发者用几行代码即可搭建复杂模型(如 Transformer),无需手动编写底层循环或硬件交互代码。

高效计算支持:优化底层计算(如利用 CUDA 调用 GPU、算子融合、内存复用),让算法在硬件上高效运行(例如,框架对卷积算子的 GPU 优化可将计算速度提升百倍)。

训练流程管理:提供自动微分(反向传播的自动实现)、分布式训练(多卡 / 多机协同)、断点续训等功能,解决大规模数据和模型训练的工程难题(如训练千亿参数模型需框架支持分布式通信)。

3. 二者的协同关系:相互驱动、缺一不可

(1)算法是框架的 “设计目标”,推动框架进化

新算法的出现会对框架提出新需求,倒逼框架升级。例如:

早期框架(如 Caffe)仅支持静态计算图,难以灵活实现 RNN 等动态序列模型,因此 PyTorch 等支持动态图的框架应运而生;

Transformer 模型的 “多头注意力” 需要高效的矩阵运算,框架随之优化了bmm(批量矩阵乘法)等算子;

大模型训练需要千亿级参数存储,框架推出了模型并行、混合精度训练等功能。

(2)框架是算法的 “落地载体”,决定算法的可行性

框架的能力直接限制或促进算法的应用范围:

没有框架的自动微分功能,手动实现深度学习模型的反向传播会极其繁琐(需推导数百个参数的梯度公式),导致复杂算法难以落地;

框架的分布式能力让 “大模型(如 GPT-4)” 从理论算法变为现实(单卡无法容纳千亿参数,需框架支持多设备协同);

框架的硬件适配(如支持 FPGA、TPU)让算法能在特定场景(如边缘设备)高效运行。

(3)框架降低算法门槛,加速创新迭代

框架封装了底层细节后,开发者无需关注 “如何让代码在 GPU 上跑”,而是专注于 “如何改进算法逻辑”。例如:

研究者用 PyTorch 只需几十行代码就能修改 Transformer 的注意力机制,快速验证新算法的有效性;

工程师通过调用框架的预训练模型接口(如 Hugging Face Transformers),可直接将 BERT、GPT 等复杂算法应用于实际业务(如文本分类),无需重复实现。

总结

算法是 AI 的 “核心逻辑”,定义了 “解决问题的思路”;框架是 “工程工具”,提供了 “实现思路的基础设施”。二者如同 “思想与纸笔”:没有算法,框架只是空壳;没有框架,复杂算法难以落地。它们的协同推动了 AI 从理论到应用的快速发展。

需求留言:

需求留言: