一、碎片化部署:AI 新范式

大模型碎片化部署是指将原本集中在云端的大模型推理能力,通过轻量化技术下沉到靠近数据源的边缘设备,形成 "云 - 边 - 端" 协同的分布式 AI 架构。

核心优势:

超低延迟:数据本地处理,响应时间从秒级降至毫秒级;

隐私保护:敏感数据不出本地,避免云端泄露风险;

带宽节约:大幅减少上传至云端的数据量,特别适合 5G/6G 受限场景;

成本优化:降低云端算力成本,支持离线 / 弱网环境运行;

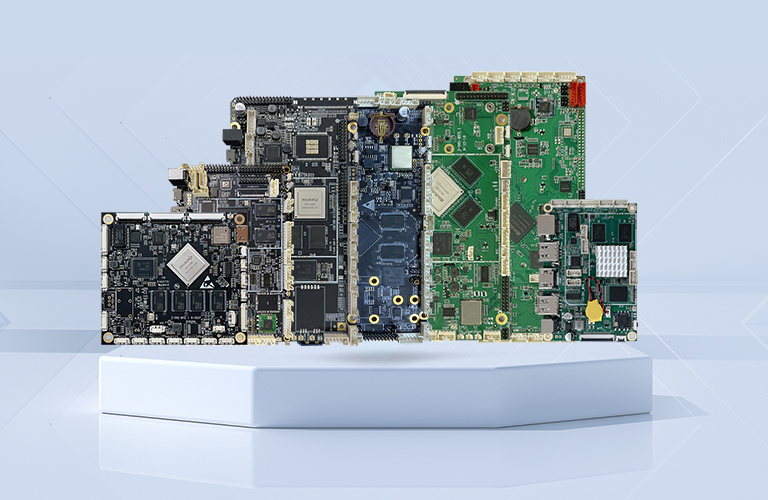

二、边缘算法盒子:三大核心组件详解

1. GPU:边缘算力引擎

为什么选择 GPU?

并行计算:数百至上千个 CUDA 核心,专为矩阵运算优化,比 CPU 快数十倍;

AI 加速:内置 Tensor Core,对深度学习推理提供硬件级加速;

生态完善:CUDA、cuDNN、TensorRT 等成熟工具链,大幅降低开发门槛;

主流 GPU 选型指南:

型号 | 算力 | 功耗 | 适用场景 |

NVIDIA Jetson AGX Orin | 275 TOPS (INT8) | 70W | 工业质检、自动驾驶 |

NVIDIA Jetson Nano | 472 GFLOPS | 5-10W | 轻量级视觉、IoT 终端 |

AMD Radeon E9260 | - | 低功耗 | 嵌入式工控、智能零售 |

国产昇腾 310P / 寒武纪 MLU220 | 8-16 TOPS | 15-30W | 信创项目、边缘推理 |

关键技术点:

模型量化:FP32→INT8,模型体积减少 75%,推理速度提升 2-4 倍,精度损失控制在 2% 以内;

动态图优化:算子融合、常量折叠,减少内存访问,推理延迟降低 30-50%;

模型分片:将大模型拆分为多个子模型,按需加载,解决边缘设备内存瓶颈 (4GB→16GB);

2. 轻量化 OS:边缘系统灵魂

轻量化 OS 的核心特征:

特性 | 实现方式 | 优势 |

极小体积 | 仅保留核心内核和必要服务,去除冗余组件 | 512MB 内存即可运行完整功能 |

启动极速 | 容器化部署,镜像 < 50MB,启动 < 1 秒 | 断电恢复时间从分钟级降至秒级 |

模块化设计 | 组件按需裁剪,支持动态加载 / 卸载 | 系统资源占用降低 60-80% |

实时响应 | 专用实时内核,任务调度延迟 < 1ms | 满足工业控制、自动驾驶等严苛场景 |

主流轻量化 OS 对比:

OS 名称 | 特点 | 适用设备 |

openEuler Minimal | 华为自研,支持容器 (iSula/ Docker),模块化裁剪 | 工业网关、边缘服务器 |

Ubuntu Core | Snap 包管理,自动更新,安全隔离 | 消费级 IoT 设备、树莓派系列 |

Alpine Linux | 体积 < 5MB,musl libc 替代 glibc | 内存 < 1GB 的超轻量设备 |

NVIDIA IGX OS | Jetson 专用,集成 CUDA/ TensorRT,企业级支持 | AGX 系列,工业环境部署 |

轻量级 K3s | Kubernetes 精简版,资源占用极低 | 边缘集群管理,多设备协同 |

关键技术点:

进程级部署:仅启动必要服务,内存占用控制在 MB 级;

容器化隔离:cgroups/namespace 实现进程隔离,防止服务间干扰;

硬件适配层:统一抽象不同架构 (ARM/x86/RISC-V),实现 "一次开发,多端部署";

3. 加密模块:数据安全堡垒

为什么边缘设备需要加密?

防止模型被盗取或逆向工程;保护传输和存储的数据隐私;确保设备身份唯一,防止伪造。

加密模块三大核心功能:

功能 | 技术实现 | 应用场景 |

模型加密 | AES-256-GCM 对权重加密,SHA-256 对结构签名 | 防止模型被窃取和非法使用 |

数据保护 | 同态加密、TEE (可信执行环境) | 医疗影像分析、金融风控 |

安全通信 | TLS 1.3 + 国密算法 (SM2/SM3/SM4) | 设备与云端、设备间数据传输 |

加密技术全景:

加密类型 | 实现方案 | 优势 |

静态加密 | 模型文件加密存储,仅授权设备可解密 | 防止存储介质丢失导致的模型泄露 |

运行时加密 | 同态加密 (HE)、安全飞地 (SGX/TDX) | 密文状态下直接计算,保护中间结果 |

硬件绑定 | 基于 TPM 2.0/HSM 生成设备唯一密钥对 | 模型只能在授权设备上运行,防止盗版 |

联邦学习 | 模型分片 + 安全聚合,各节点仅持部分参数 | 多方协作不泄露原始数据 |

关键技术点:

轻量级算法:针对边缘设备优化的加密算法,如 AES-GCM、SM4,平衡安全与性能;

动态密钥管理:密钥生命周期管理,定期更新,防止长期暴露风险;

硬件加速:利用 GPU/NPU 的专用指令加速加密运算,如 NVIDIA 的 AES 指令集;

三、三位一体:协同构建边缘智能

边缘算法盒子完整架构:

三大组件协同工作流程:

模型准备:云端将大模型通过量化、剪枝、蒸馏等技术轻量化,生成加密模型包

边缘部署:

GPU 负责高性能推理计算,处理密集型矩阵运算;轻量化 OS 提供极简运行环境,管理资源调度和进程隔离;加密模块负责模型解密、数据保护和通信安全。

推理执行:

加密模块验证设备身份,解密模型分片;GPU 执行推理计算,OS 负责内存优化和任务调度;结果本地处理或加密上传至云端,全程保护数据隐私。

四、典型应用场景

1. 智能制造质检

部署:边缘盒子置于生产线旁,实时分析产品图像;

优势:检测速度达毫秒级,不良品识别准确率 > 99.9%,节省 90% 带宽,保护工业机密;

2. 智能安防监控

部署:摄像头端集成边缘盒子,本地分析视频流;

优势:人脸 / 行为识别实时响应,敏感视频片段本地脱敏,带宽消耗降低 80%;

3. 医疗健康监测

部署:便携式医疗设备内置边缘盒子,分析生理数据;

优势:隐私数据本地处理,异常预警毫秒级响应,支持离线诊断;

4. 自动驾驶辅助

部署:车载边缘计算平台,处理多路摄像头和雷达数据;

优势:决策延迟 < 50ms,支持复杂路况实时分析,降低对高带宽的依赖;

五、未来发展趋势

算力密度提升:新一代边缘 GPU 算力突破 1000 TOPS,功耗降至 50W 以下;

更轻量的模型:通过神经架构搜索 (NAS) 和知识蒸馏,模型体积将进一步缩小 50-90%;

安全增强:全同态加密 (CKKS) 实用化,实现 "密文计算 + 明文结果" 的理想安全模型;

自主进化:边缘设备支持模型本地微调,通过联邦学习持续优化,减少对云端依赖;

总结

边缘算法盒子通过GPU + 轻量化 OS + 加密模块的黄金组合,已成为大模型碎片化部署的理想载体。这一架构不仅解决了传统 AI 部署的延迟、隐私和带宽问题,还为智能制造、智能城市、医疗健康等领域带来了全新可能。

选择边缘算法盒子时,建议根据应用场景平衡算力需求、功耗限制和安全要求,构建最适合的边缘 AI 解决方案。

注:本文信息基于 2025 年 11 月前的技术发展情况,随着 AI 硬件和算法的快速迭代,具体参数可能会有变化。

需求留言:

需求留言: