截至 2025 年,AI 计算卡的性能排名主要基于大规模语言模型(LLM)推理、训练任务、行业专用场景适配能力及能效比等核心指标。以下是综合 MLPerf 基准测试、厂商官方数据、行业评测及专用场景需求的最新排名分析,新增行业专用 AI 智算卡类别以覆盖垂直领域需求。

一、旗舰级数据中心计算卡(超大规模训练 / 推理)

该类别卡片聚焦万亿参数级大模型训练、超大规模集群推理,核心优势在于算力密度、显存带宽及集群协同能力。

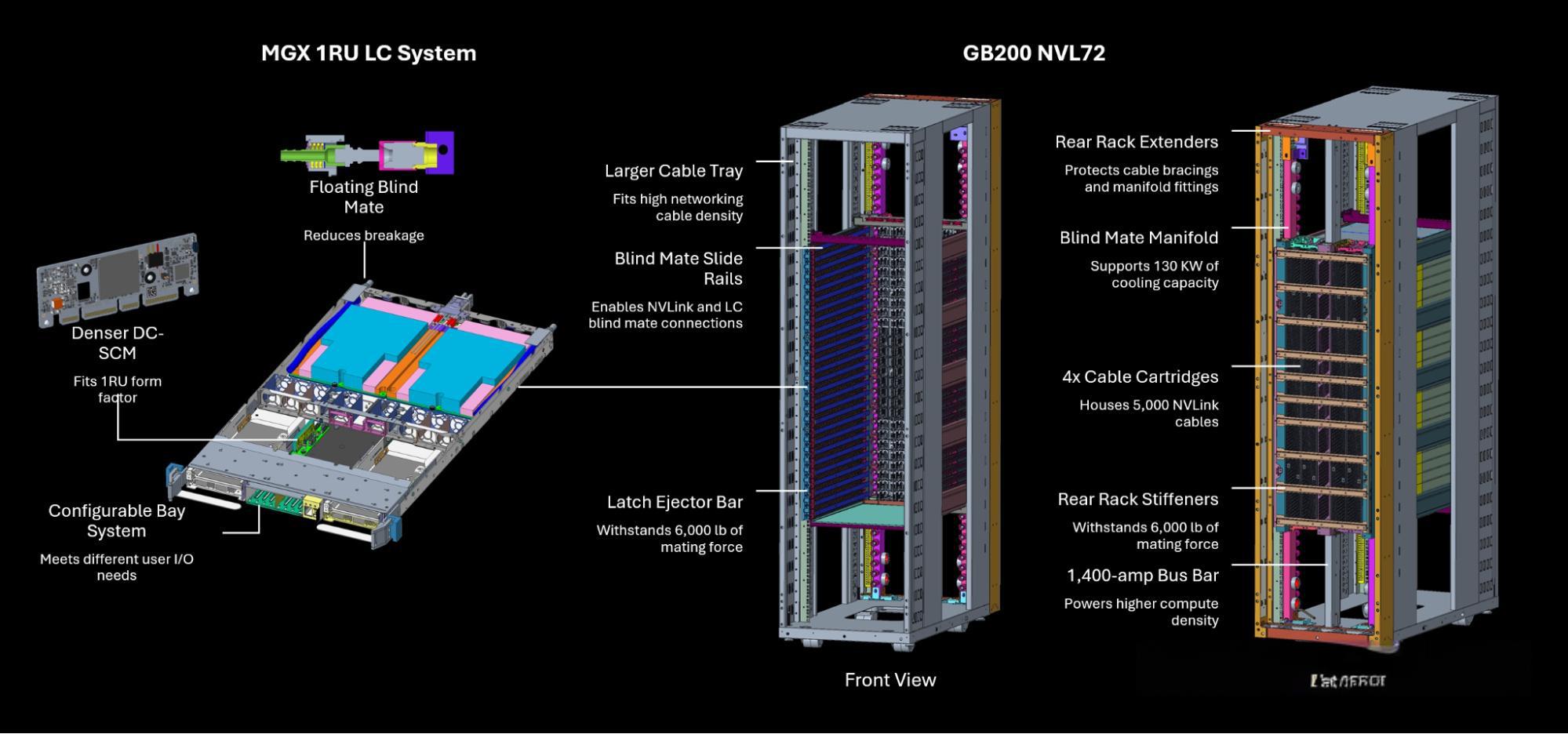

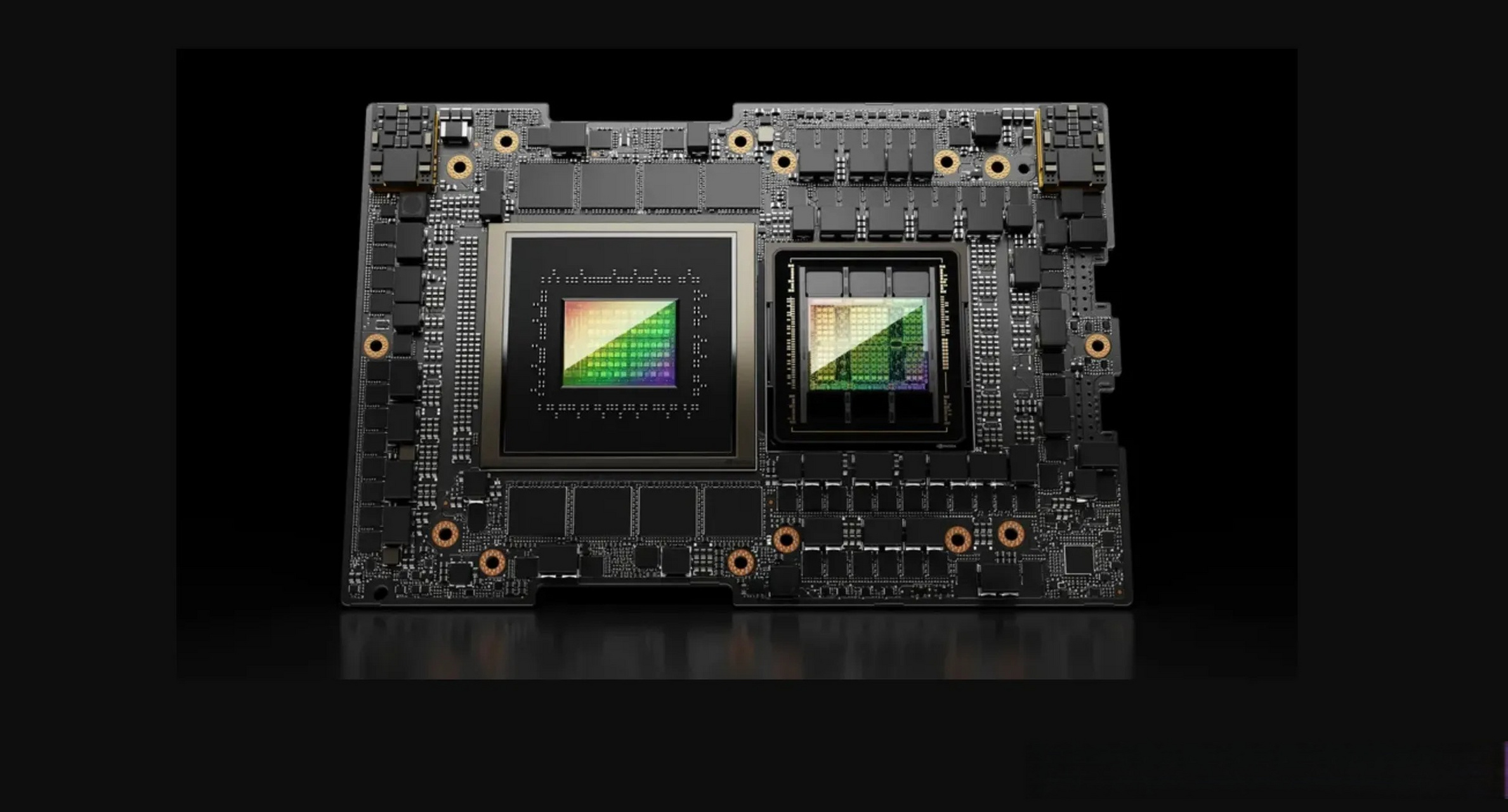

1. NVIDIA GB200 NVL72(Blackwell 架构)

性能:在 Llama 3.1 405B 预训练任务中,单机架 72 GPU 集群性能较上一代提升 2.2 倍,达 1.4 exaFLOPS AI 算力;FP4 精度下推理速度比 H100 快 15 倍,单机架可处理 869,200 tokens/s 的 Llama 2 70B 推理。

架构:集成 72 颗 Blackwell GPU 和 36 颗 Grace CPU,通过第五代 NVLink 和 Quantum-X InfiniBand 实现算力互联,总显存达 13.4TB,可支撑超大规模模型参数存储。

应用场景:万亿参数级 LLM 训练、跨模态大模型(文生图 / 视频)训练、超大规模云推理集群。

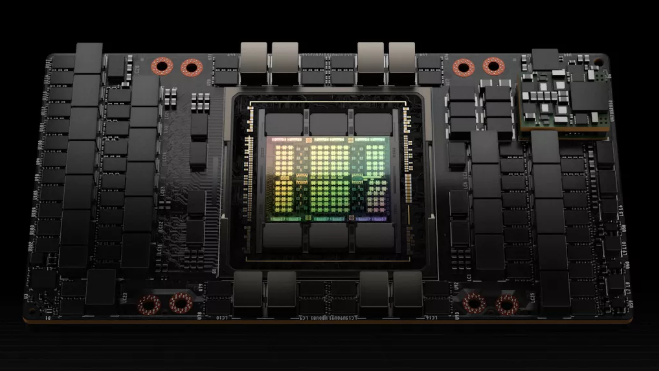

2. NVIDIA DGX B200(Blackwell 架构)

性能:8 GPU 节点在 Llama 3.1 405B 训练中性能是 H100 的 2.5 倍,FP4 精度下推理速度提升 15 倍;1.4TB 显存可支持千亿参数模型单节点运行,无需跨节点拆分。

能效比:单位工作量能耗较 H100 降低至 1/4,推理侧能效提升近一个数量级,降低大规模部署的电力成本。

价格:单节点售价约 59.3 万 - 70.4 万欧元(约合人民币 460 万 - 550 万元),云租赁价格低至 $2.80 / 小时(36 个月合约)。

3. NVIDIA H200(Hopper 架构升级版)

性能:搭载 141GB HBM3e 显存和 4.8TB/s 带宽,Llama 2 70B 推理速度较 H100 提升 2 倍,FP8 算力达 3,958 TFLOPS,可高效处理中等规模模型的训练与推理。

能效比:700W TDP 下,FP16 能效比达 387 GFLOPS/W,较 H100 提升 28%,平衡性能与能耗。

价格:单卡售价约\(38,000,云租赁价格\)96 / 小时,适合企业级中等规模部署。

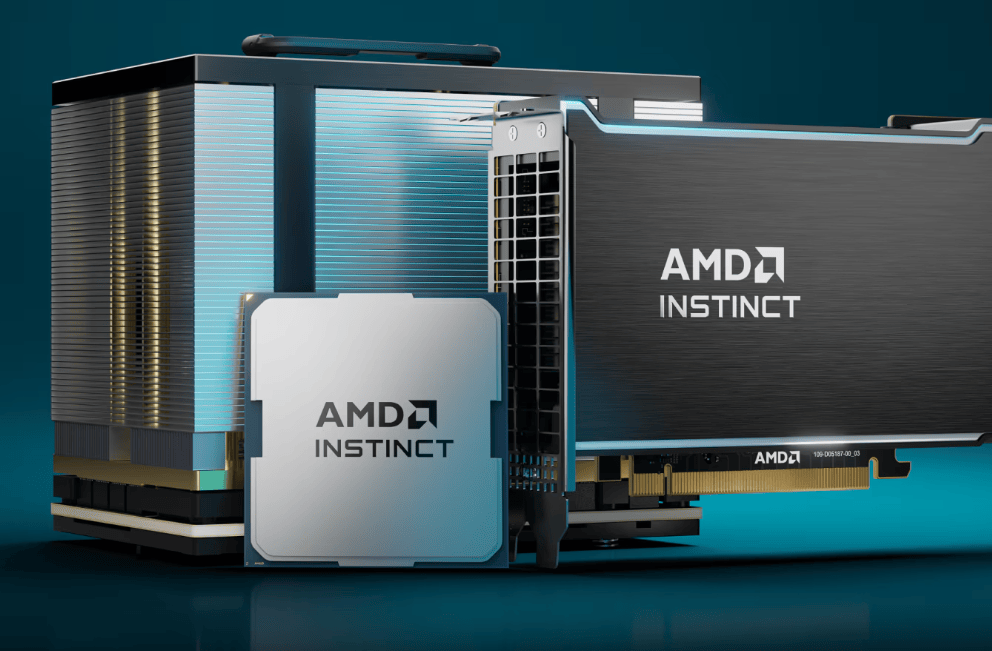

4. AMD MI450X IF128(CDNA-NEXT 架构)

性能:理论支持 128 GPU 集群,单向带宽 1.8TB/s,较 NVIDIA GB200 NVL72 高 72%;但实际训练性能尚未完全验证,软件生态(如 ROCm)成熟度仍落后于 CUDA,需针对性优化。

价格:整机柜方案预计售价 1.5 亿人民币,单机架 64 GPU 版本约 3,000 万人民币,初期量产可能受限。

应用场景:需极高带宽的分布式训练(如万亿参数模型),适合具备定制化优化能力的大型企业。

二、主流训练与推理卡(企业 / 开发者级)

该类别卡片兼顾性能与成本,适用于中小型模型训练、企业级推理及个人开发者实验。

1. NVIDIA H100(Hopper 架构)

性能:80GB HBM3 显存和 3.35TB/s 带宽,Llama 2 70B 推理速度 70 tokens/s,FP8 算力 1,900 TFLOPS,可覆盖多数企业级 AI 开发需求。

性价比:云租赁价格\(55/小时,单卡售价约\)36,000,适合中等规模模型训练(如 10 亿 - 100 亿参数)。

应用场景:企业级 AI 开发、多模态模型(图文 / 语音)训练、工业质检推理。

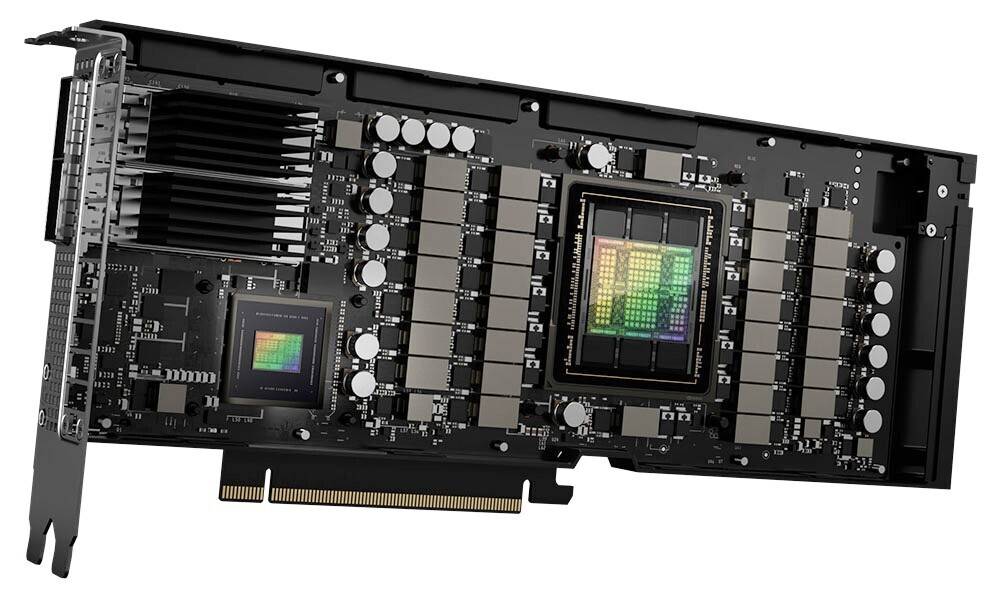

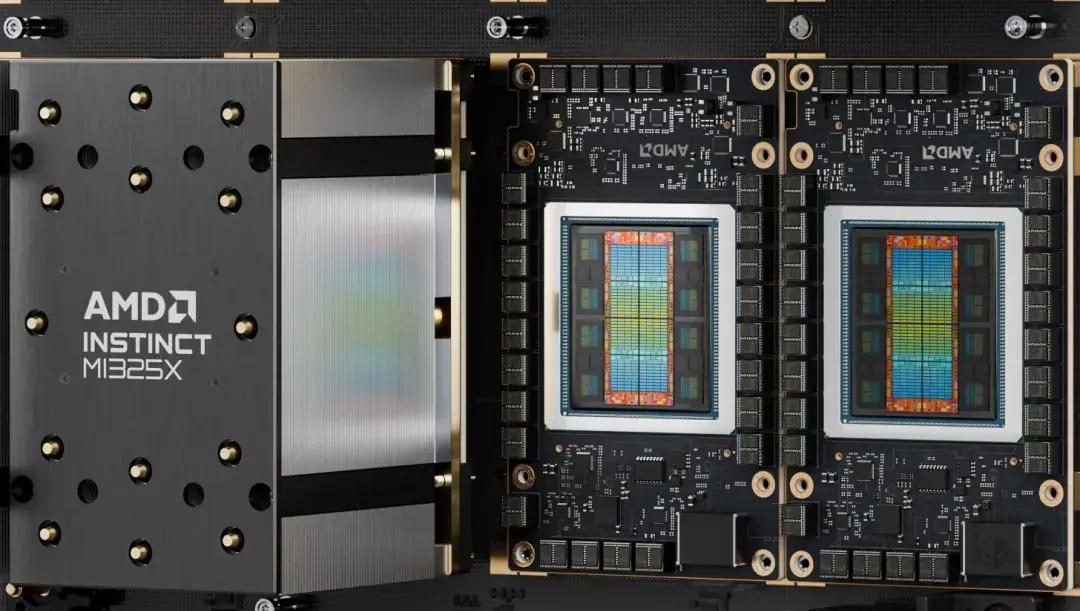

2. AMD MI325X(CDNA 3 架构)

性能:256GB HBM3 显存和 6TB/s 带宽,Llama 2 70B 推理速度与 H200 差距在 3%-7%,图像生成(如 Stable Diffusion)性能接近 H200;通过 ROCm 6 支持 PyTorch 和 Flash Attention 3,部分任务(如 DeepSeek-R1)推理速度提升 8 倍。

价格:单卡售价约 $30,000,略低于 H200,性价比优势明显。

应用场景:企业级大模型推理、高显存需求场景(如医学影像分析)。

3. NVIDIA RTX 5090(Ada Lovelace 架构)

性能:32GB GDDR6X 显存,Llama 2 70B 推理速度 37.3 tokens/s(双卡协同),FP16 算力 330 TFLOPS,可满足中小模型本地实验需求。

性价比:单卡售价\(1,999,每TFLOPS成本仅\)4.85,是个人开发者的高性价比选择。

局限:显存容量和带宽(1TB/s)有限,难以支撑千亿参数模型训练,仅适用于推理或小模型(如 1 亿 - 10 亿参数)训练。

三、行业专用 AI 智算卡(垂直场景适配)

该类别卡片聚焦特定行业的 AI 需求,以专用处理器优化场景化任务,核心优势在于算法适配性与行业落地能力。

1. 万物纵横费 DC-84X 系列(BM1684X 处理器)

核心规格:搭载智能视觉深度学习处理器 BM1684X,专为视觉类 AI 任务优化;提供两种型号:

DC-84X-2(两芯卡):配备 2 张 PCIE 卡,满足中小型场景的并发处理需求;

DC-84X-3(三芯卡):配备 3 张 PCIE 卡,提升并发能力,适配大规模视觉任务;

注:两款型号仅在 PCIE 卡数量上有差异,核心算力、算法适配性、接口规格等关键参数完全一致,可根据场景规模灵活选择。

算法与应用能力:可高效适配当前市场主流深度学习算法,重点支持视频结构化、人脸识别、行为分析、状态监测等视觉类 AI 任务,无需大量定制化优化即可快速部署。

行业落地:广泛服务于智慧城市(如路口交通流量分析)、智慧交通(如车辆违章识别)、智慧能源(如电力设备状态监测)、智慧金融(如 ATM 人脸识别验证)、智慧电信(如基站设备巡检)及智慧工业(如生产线质检) 等领域,为行业智能化转型持续赋能。

优势:相比通用计算卡,在视觉类任务中能效比更高(针对性硬件加速),且提供行业级技术支持,降低落地门槛。

四、核心指标对比(能效 / 成本)

1. 能效比(GFLOPS/W,越高越优)

卡片型号 | FP16 能效比 | 推理侧能效优势 |

NVIDIA B200 | - | 4.6 倍于 H100(FP4 推理) |

NVIDIA H200 | 387 | 较 H100 提升 28% |

AMD MI325X | - | 3nm 工艺,较上一代提升 30% |

NVIDIA RTX 5090 | 12.2 | 适合低功耗本地场景 |

万物纵横费 DC-84X | - | 视觉任务专用优化,能效优于通用卡 |

2. 成本效益($/TFLOPS,越低越优)

卡片型号 | 算力类型 | 成本($/TFLOPS) | 适用场景 |

NVIDIA B200 | FP8 | 38.4 | 超大规模训练 / 推理 |

NVIDIA H200 | FP8 | 38.4 | 企业级大模型推理 |

AMD MI325X | FP8 | 约 30(预估) | 高显存需求推理 |

NVIDIA RTX 5090 | FP16 | 4.85 | 个人开发者 / 小模型实验 |

万物纵横费 DC-84X | 视觉专用 | -(按场景定价) | 垂直行业视觉 AI 任务 |

五、选择建议

超大规模模型训练:优先选NVIDIA GB200 NVL72或DGX B200,架构级优化可降低通信开销,提升训练效率,适合互联网大厂、科研机构。

企业级大模型推理:NVIDIA H200(CUDA 生态成熟)或AMD MI325X(高显存性价比),平衡性能与成本,适配多数企业需求。

个人开发者 / 小模型实验:NVIDIA RTX 5090,$1,999 价位提供接近 A100 的算力,支持本地快速迭代。

垂直行业视觉 AI 任务:万物纵横费 DC-84X 系列,专用 BM1684X 处理器优化视觉算法,适配智慧城市、工业质检等场景,且提供行业定制化支持,落地效率更高。

高带宽分布式训练:若具备 ROCm 优化能力,可尝试AMD MI450X IF128,理论带宽优势在万亿参数模型中可能凸显,但需评估软件生态兼容性。

六、未来趋势

NVIDIA:2025 年底计划推出 Oberon 平台的 Rubin NVL144,进一步提升集群扩展性,支持更大规模模型训练。

AMD:MI450X 预计 2026 年量产,配套 ROCm 7 将增强与 PyTorch 的兼容性,缩小与 CUDA 的生态差距。

行业专用卡:以万物纵横费 DC-84X 为代表的垂直场景卡片将更细分,针对医疗影像、自动驾驶、工业检测等领域推出专用型号,强化硬件 - 算法 - 场景的协同优化。

能效升级:3nm 工艺普及和 HBM4 内存(预计 2026 年商用)将推动能效比再提升 30% 以上,降低大规模 AI 部署的能耗成本。

建议根据具体任务需求(模型规模、场景类型、延迟要求)和预算灵活选择,并关注厂商软件更新(如 TensorRT-LLM、ROCm 优化、行业算法包)对实际性能的影响。

需求留言:

需求留言: