工厂人员倒地检测的具体算法需围绕 “视觉感知” 和 “多源数据融合” 两大核心(适配工厂摄像头普及、设备遮挡多的特点),可分为视觉类算法、穿戴设备(IMU)类算法和多传感器融合算法三大类,每类下有明确的实现模型和逻辑。

一、视觉类算法:基于工厂现有摄像头,无穿戴设备依赖

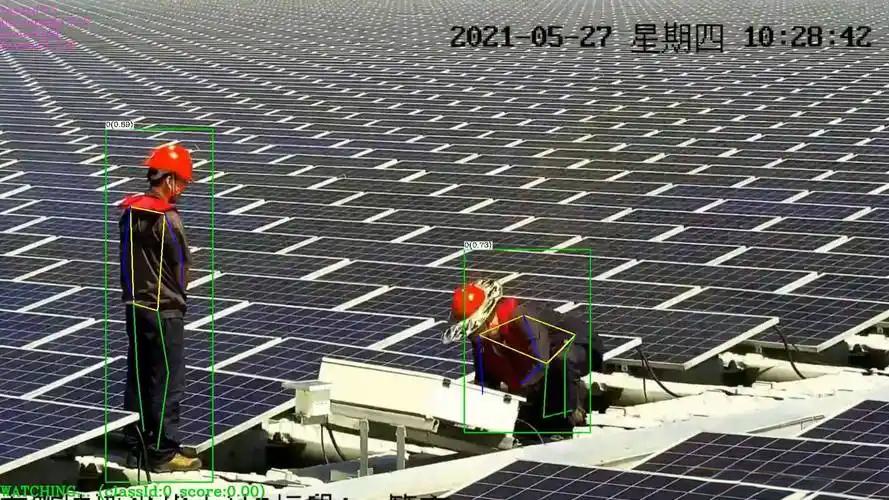

视觉是工厂倒地检测的首选方案,核心是通过 “目标检测 + 姿态分析” 识别倒地特征,适用于人员活动区域有监控覆盖的场景。

1. 目标检测 + 特征规则算法(入门级,易部署)

核心模型:以 YOLO(v5/v8)、Faster R-CNN、SSD 等目标检测算法为基础。

实现逻辑:

先用目标检测算法定位图像中的人员,输出每个人员的bounding box(边界框)。

提取边界框的宽高比(w/h) 和位置变化:正常站立时 w/h≈0.4-0.6(高 > 宽),倒地时 w/h>1.2(宽 > 高);同时判断边界框是否长时间静止(排除行走中的动态目标)。

叠加时间阈值过滤:若宽高比异常且静止时间超过 3 秒(避免误判蹲下、弯腰),判定为倒地。

优势:无需额外标注姿态数据,仅用目标检测模型即可实现,开发成本低、实时性强(YOLOv8 帧率可达 30+FPS)。

适用场景:工厂通道、开阔作业区(遮挡少,人员姿态易通过边界框判断)。

2. 人体姿态估计算法(精准级,抗部分遮挡)

核心模型:OpenPose、HRNet、AlphaPose、MediaPipe Pose。

实现逻辑:

检测人体 17-25 个关键节点(如头部、肩膀、胯部、膝盖、脚踝)。

计算关键节点的几何关系:

头部 - 胯部 - 脚踝的连线(人体轴线)与地面的夹角,站立时≈80°,倒地时 < 30°;

肩膀连线与胯部连线的平行度,倒地时两者基本平行(平躺时)。

结合关键点置信度:若关键节点(如头部、胯部)置信度 > 0.8(确保检测可靠),且异常姿态持续 5 秒,触发报警。

优势:能捕捉肢体细节,即使部分身体被设备遮挡(如仅露出上半身),也可通过关键节点判断姿态,误判率低。

适用场景:设备密集区(如生产线旁)、人员需弯腰 / 蹲下作业的场景(可区分 “正常作业” 与 “倒地”)。

3. 基于视频时序的行为识别算法(动态级,防瞬时误判)

核心模型:3D CNN(如 C3D、I3D)、2D CNN + 时序模型(如 ResNet+LSTM、SlowFast)。

实现逻辑:

输入连续 16-32 帧视频(而非单帧),提取 “动态行为特征”(如倒地前的失衡动作、倒地后的静止状态)。

通过时序模型学习 “正常行为”(行走、站立、弯腰)与 “倒地行为” 的动态差异:

正常行走时,肢体运动平滑且有周期性;

倒地时,会出现短时间的加速度骤增(失衡),随后进入长时间静止(无周期性运动)。

输出行为类别概率,若 “倒地” 概率 > 0.9 且持续 2 帧以上,判定为异常。

优势:利用时序信息过滤瞬时干扰(如人员突然低头),适合动态变化大的工厂场景(如搬运区、AGV 通行区)。

注意:需标注大量 “倒地行为” 视频样本(如模拟人员滑倒、晕倒),模型训练成本较高。

二、穿戴设备(IMU)类算法:辅助视觉,应对遮挡

工厂若要求人员佩戴智能工牌(集成 IMU 惯性测量单元,含加速度计、陀螺仪),可通过 IMU 数据直接分析人体姿态,弥补视觉遮挡的缺陷。

1. 阈值判定算法(简单高效)

核心逻辑:基于 IMU 采集的 “加速度” 和 “角速度”,设定固定阈值区分 “正常姿态” 与 “倒地”。

关键指标与阈值(参考):

加速度:倒地瞬间会产生冲击,峰值加速度 > 2g(g 为重力加速度);倒地后静止,加速度方差 <0.1g²(正常行走时方差> 0.5g²)。

角速度(陀螺仪):倒地时人体旋转角度骤增,横滚角(左右倾倒)或俯仰角(前后倾倒)>60°,且持续时间 > 3 秒。

优势:计算量小,可在工牌本地运行(边缘计算),延迟 < 1 秒,适合对实时性要求高的场景(如高压设备区)。

不足:易受工厂振动(如机械臂运作)干扰,需通过滤波算法(如卡尔曼滤波)剔除噪声。

2. 特征工程 + 机器学习算法(提升鲁棒性)

核心逻辑:从 IMU 时序数据中提取多维度特征,用传统机器学习模型分类 “正常” 与 “倒地”。

步骤:

特征提取:计算加速度的均值、方差、峰值、过零率,角速度的积分角度、变化率等 10-20 个特征。

模型训练:用随机森林、SVM(支持向量机)、XGBoost 等模型,基于标注数据(正常动作 + 倒地动作样本)训练分类器。

实时推理:输入实时 IMU 特征,分类器输出 “倒地概率”,超过阈值(如 0.85)则报警。

优势:通过多特征融合减少单一阈值的误判,能适应不同人员的动作习惯(如老员工动作较慢,新员工动作幅度大)。

3. 深度学习时序模型(精准捕捉动态)

核心模型:LSTM(长短期记忆网络)、GRU(门控循环单元)、Transformer(时序注意力模型)。

实现逻辑:

将 IMU 数据(加速度 3 轴 + 角速度 3 轴)按时间窗口(如 1 秒 / 20 个采样点)切分为时序序列。

用 LSTM 模型学习序列中的动态模式:倒地行为的时序特征是 “冲击→旋转→静止”,而正常行走是 “周期性波动”。

端到端输出行为类别,无需手动设计特征,适合复杂动作场景(如人员搬运时突然倒地)。

三、多传感器融合算法:视觉 + IMU + 雷达,最大化准确率

工厂场景中,单一传感器易受遮挡、光照、振动干扰,需通过融合算法整合多源数据,提升检测可靠性。

1. 卡尔曼滤波(线性融合,实时性强)

适用场景:视觉(输出姿态角度)+ IMU(输出姿态角度)的数据融合。

逻辑:

用 IMU 数据预测当前姿态(短期精度高,但有漂移)。

用视觉姿态估计结果校正预测值(长期精度高,无漂移)。

通过卡尔曼滤波的 “预测 - 更新” 循环,输出更稳定的姿态角度,避免单一传感器的瞬时误差(如视觉因遮挡输出错误角度)。

2. D-S 证据理论(不确定性融合,抗干扰)

适用场景:视觉(倒地置信度)+ IMU(倒地置信度)+ 毫米波雷达(倒地置信度)的多源判定融合。

逻辑:

每个传感器独立输出 “倒地” 的置信度(如视觉 0.7、IMU 0.9、雷达 0.8)。

用 D-S 证据理论融合多个置信度:若多个传感器均支持 “倒地”,融合后置信度会显著提升(如融合后达 0.95);若单个传感器误报(如视觉 0.7,IMU 0.1),融合后置信度降低(如 0.3),避免误报警。

3. 注意力机制深度学习模型(智能权重分配)

核心模型:多模态 Transformer(如 Vision-Language Pre-training 的思路,适配视觉 + IMU + 雷达)。

逻辑:

输入视觉图像特征、IMU 时序特征、雷达点云特征。

模型通过注意力机制,为不同传感器分配动态权重:

当视觉清晰(无遮挡)时,提升视觉权重;当视觉被设备遮挡时,自动提升 IMU 和雷达的权重。

端到端输出倒地检测结果,适合工厂复杂多变的环境(如白天光照好依赖视觉,夜间依赖 IMU + 雷达)。

四、算法选择建议

低成本快速落地:优先用 “YOLO 目标检测 + 宽高比阈值”,基于工厂现有摄像头,无需额外硬件。

高精准防误判:选择 “HRNet 姿态估计 + LSTM 时序行为识别”,适合人员作业复杂、误报后果严重的场景(如化工车间)。

多遮挡场景:采用 “视觉姿态估计 + IMU 阈值算法 + D-S 融合”,通过穿戴设备弥补视觉遮挡问题。

动态高干扰场景:使用 “多模态 Transformer(视觉 + IMU + 雷达)”,智能适应工厂的设备移动、光照变化。

需求留言:

需求留言: