AI 训练卡和计算卡是人工智能计算领域的两大核心硬件,分别针对深度学习的训练和推理阶段设计,在架构、性能指标和应用场景上存在显著差异。以下是基于最新技术动态的详细解析:

一、核心定位与技术差异

1. 训练卡:暴力计算的「超级工厂」

核心目标:快速完成神经网络的反向传播和参数更新,支撑大规模模型训练(如千亿参数大模型)。

技术特性:

超高算力:搭载大量 Tensor Core 或矩阵运算单元。例如,NVIDIA H200 采用 Hopper 架构,FP8 算力达 3958 TFLOPS,较上一代 H100 提升 60%-90%。

超大显存:需存储模型参数、梯度和中间结果。H200 配备 141GB HBM3e 显存,带宽 4.8TB/s,可完整加载 GPT-3 等巨型模型而无需分片。

高功耗设计:单卡功耗通常超过 400W(如 H200 为 700W),依赖液冷或相变材料散热。

多卡互联:支持 NVLink 等高速接口,实现多卡协同。H200 的 NVLink 4.0 带宽达 900GB/s,8 卡集群算力接近线性扩展。

2. 计算卡:高效推理的「智能终端」

核心目标:用训练好的模型快速生成预测结果,注重实时性和能效比。

技术特性:

低精度优化:支持 INT8/FP16 混合精度计算。例如,NVIDIA T4 的 TensorRT 引擎可将 ResNet-50 推理延迟降至 1ms 以下。

低功耗设计:功耗通常低于 200W。高通 AI200 推理芯片功耗仅 150W,能效比 A100 高 30%。

灵活部署:支持边缘计算场景,如寒武纪思元 370 推理卡功耗 20W,可集成到智能摄像头。

轻量架构:显存容量较小(如 T4 为 16GB GDDR6),但带宽优化(320GB/s)以满足实时数据吞吐。

二、典型产品与性能对比

指标 | 训练卡(以 H200 为例) | 计算卡(以 T4 为例) |

算力 | FP8:3958 TFLOPS;FP16:1979 TFLOPS | INT8:65 TOPS;FP16:130 TFLOPS |

显存 | 141GB HBM3e,4.8TB/s 带宽 | 16GB GDDR6,320GB/s 带宽 |

功耗 | 700W(典型) | 70W(典型) |

多卡支持 | NVLink 4.0,8 卡集群 | 单卡或小规模集群 |

适用模型规模 | 千亿参数大模型(如 GPT-4) | 万至亿参数模型(如 BERT) |

典型延迟 | 分钟级(训练周期) | 毫秒级(推理响应) |

三、应用场景与行业案例

1. 训练卡的核心战场

大模型训练:H200 在某 AI 研究院训练万亿参数语言模型时,效率提升 35%,收敛速度加快 20%。

科学计算:某气候研究中心用 H200 模拟全球气候,高分辨率模型计算速度提升 40%,预测精度提高 5%。

量子模拟:cuQuantum SDK 结合 H200,可将 13 量子位旋转链模拟速度提升至 CPU 的 78 倍。

2. 计算卡的落地场景

实时视频分析:爱芯元智 M.2 算力卡(基于 AX8850)在智能 NVR 中实现文搜大模型部署,功耗 < 8W,支持 480 帧 / 秒 YOLOv8 检测。

自动驾驶:特斯拉 FSD 芯片(自研计算卡)处理摄像头数据,延迟 < 100ms,支撑 L2 + 级辅助驾驶。

医疗影像:某三甲医院用昇腾 310 推理卡分析 CT 影像,单日处理量从 300 例增至 15,000 例,GPU 资源消耗减少 82%。

四、国产替代与生态竞争

1. 国产训练卡的突破

华为昇腾 910B:FP16 算力 376 TFLOPS,接近 A100 水平,成本仅为其 1/10,已在腾讯、字节跳动的千亿模型训练中规模化应用。

壁仞科技 BR100:采用 Chiplet 技术,FP16 算力 672 TFLOPS,部署于国家超算中心,支撑高性能计算需求。

2. 计算卡的差异化竞争

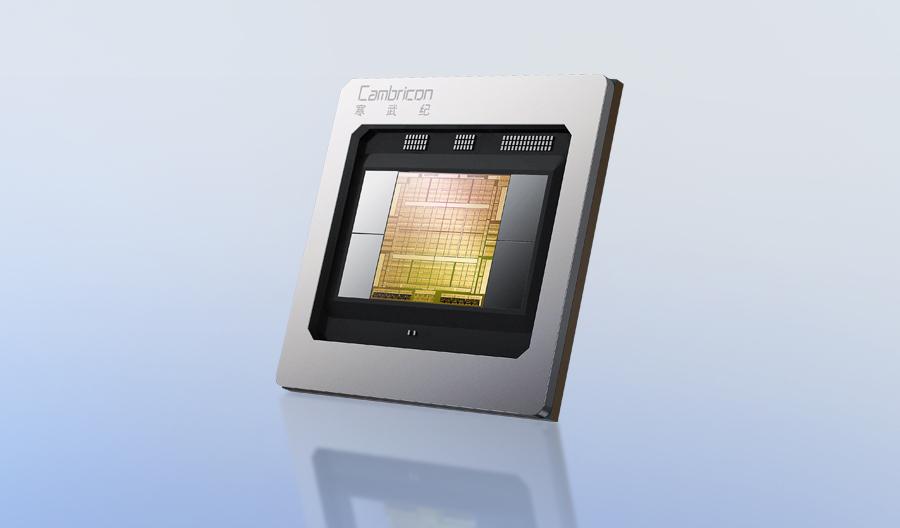

寒武纪思元 590:在视觉处理场景性能达 A100 的 80%,2025 年一季度出货量同比暴增 4230%,渗透率超 30%。

摩尔线程 MTT S80:国产消费级 GPU,支持 FP8 精度,信创领域市占率突破 60%,可满足中规模模型训练。

3. 生态系统对比

NVIDIA CUDA:行业标准,支持 PyTorch/TensorFlow 等主流框架,开发者社区超 500 万。

华为 CANN:兼容 CUDA 90% 语法,通过 MUSIFY 工具实现代码迁移,已适配 OpenCV/vLLM 等开源库,开发者超 150 万。

AMD ROCm:开源跨平台,支持 HIP 语言迁移 CUDA 代码,在边缘计算场景成本比 NVIDIA 低 30%。

五、未来趋势与选择建议

1. 技术演进方向

训练卡:向更高密度显存(如 HBM4)和更低功耗(如 3nm 工艺)发展。NVIDIA 计划 2026 年推出基于 HBM4 的 Blackwell 架构训练卡,能效比再提升 50%。

计算卡:边缘端集成 AI 原生处理器(如爱芯元智 AX8850),支持多模态大模型本地运行,延迟降至 1ms 以下。

2. 选型决策指南

大模型训练:优先选择 H200 或昇腾 910B,关注显存容量和多卡互联能力。

实时推理:根据场景选择 T4(云端)或寒武纪 MLU270(边缘),权衡延迟和功耗。

国产替代:政务、金融等敏感领域建议采用昇腾或摩尔线程产品,需提前评估生态迁移成本。

3. 成本优化策略

算力租赁:中小机构可通过猿界算力等平台租用 H200 服务器,月费约 8500 元,避免前期硬件投入。

混合部署:训练用 H200 集群,推理用 T4 或国产卡,实现资源最优分配。

AI 训练卡和计算卡的选择需紧密结合业务需求、预算和生态适配性。随着国产技术的快速崛起,未来异构计算(CPU+GPU + 国产加速卡)将成为主流,推动 AI 算力普惠化。

需求留言:

需求留言: