一、核心场景化选型方案

不同场景的核心诉求(如实时性、小目标精度、密集目标处理)差异极大,需优先明确场景指标权重,再对应选型。

1. 实时检测场景(核心指标:FPS>30,兼顾基础精度)

适用场景:车载摄像头、实时视频监控、无人机实时回传、嵌入式设备(如边缘计算盒)。

核心诉求:低延迟、高帧率,对硬件资源占用低。

算法推荐与对比:

推荐算法 | 关键优势 | 硬件要求 | 注意事项 |

YOLOv5s / v8n | 轻量化最优,FPS 达 140+(V100),开源生态成熟 | 支持 GPU/CPU/ 嵌入式(如 Jetson) | 复杂场景(如雨天、遮挡)精度略降,需补充数据增强 |

SSD MobileNet | 比 YOLO 更轻量,适合手机 / 物联网设备 | 可运行于移动端(如骁龙 8 系) | 小目标召回率较低,不适合远距离检测 |

YOLOv7-Tiny | 速度与精度平衡优于早期 SSD,对遮挡鲁棒性强 | 边缘设备(如树莓派 4B)需加速 | 需配合 TensorRT 量化加速,否则帧率不足 |

选型结论:优先选YOLOv5s/v8n,工程落地成本最低;若需部署到手机等移动端,选SSD MobileNet。

2. 高精度检测场景(核心指标:mAP@0.5>38,允许低帧率)

适用场景:医疗影像检测(如肿瘤识别)、工业质检(如芯片缺陷)、文物修复辅助。

核心诉求:目标识别准确率高,支持小目标、细微差异检测。

算法推荐与对比:

推荐算法 | 关键优势 | 适用目标类型 | 局限性 |

Mask R-CNN | 支持 “检测 + 实例分割”,小目标 mAP 最高 | 需区分目标轮廓的场景(如缺陷边缘) | FPS 仅 5(V100),需高性能 GPU |

Faster R-CNN(ResNet101) | 比 Mask R-CNN 快(FPS≈7),精度略低 | 仅需检测目标位置,无需分割 | 对密集目标(如重叠缺陷)处理能力弱 |

Cascade R-CNN | 比 Faster R-CNN 精度高 5%-8%,对模糊目标鲁棒 | 低清晰度图像(如旧医疗胶片) | 计算量更大,训练周期长 |

选型结论:需分割选Mask R-CNN,仅检测选Cascade R-CNN;若硬件有限,退选Faster R-CNN。

3. 小目标检测场景(核心指标:小目标召回率>60%)

适用场景:遥感图像(如农田作物斑点)、无人机航拍(如地面行人)、工业零件微小缺陷(如螺丝划痕)。

核心痛点:小目标像素少(通常<32×32),易被背景干扰,传统算法召回率低。

算法推荐与优化策略:

优先算法:YOLOv8x(大模型)、FCOS(无锚框,对小目标更友好)。

关键优化策略:

图像缩放:将小目标放大(如输入尺寸从 640×640 改为 1280×1280),提升像素占比。

特征融合:保留更多浅层特征(如 YOLO 的 PANet 结构),避免小目标信息在深层网络丢失。

数据增强:针对性添加 “小目标复制粘贴”“随机缩放” 增强样本多样性。

选型结论:工程落地选YOLOv8x+1280 输入尺寸,兼顾速度与小目标精度;纯科研场景可试FCOS+Deformable Conv(精度更高但部署复杂)。

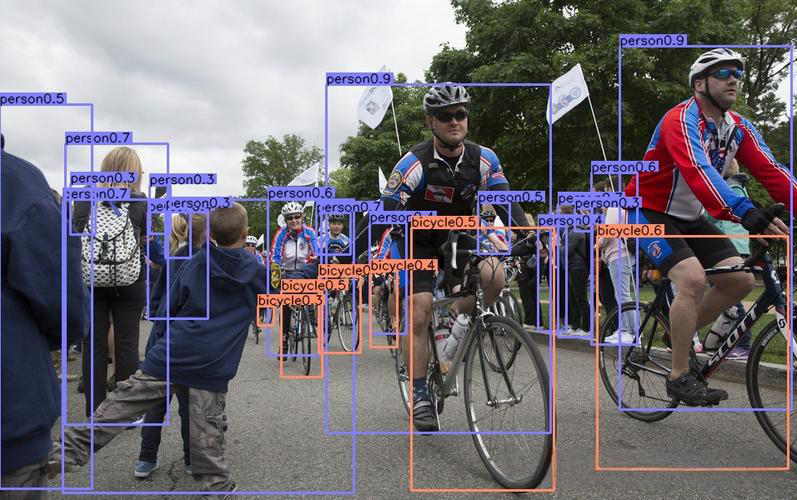

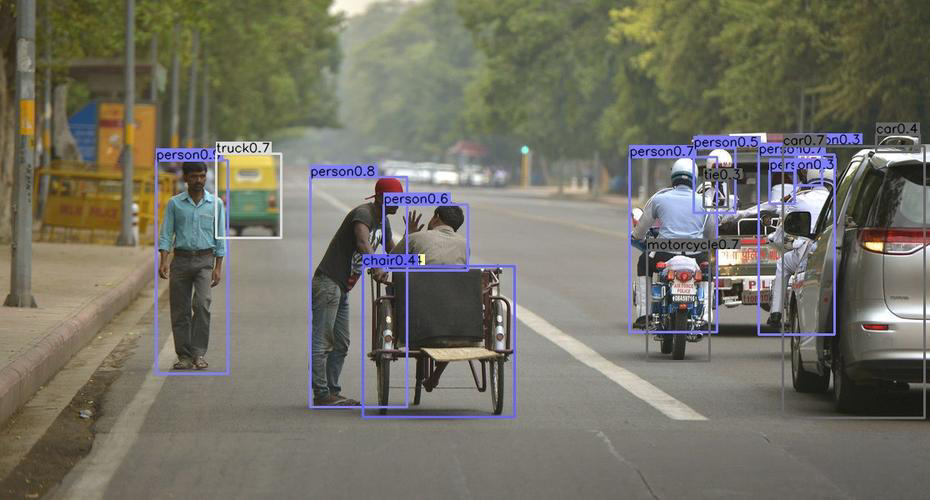

4. 密集目标检测场景(核心指标:密集目标 AP>35%)

适用场景:人群计数、交通流检测(如早高峰车流)、商场客流统计。

核心痛点:目标重叠多、遮挡严重,候选框易冲突,传统锚框算法漏检率高。

算法推荐与对比:

推荐算法 | 核心解决思路 | 密集场景 AP(COCO) | 速度 |

YOLOv7-E6 | 优化锚框匹配策略,支持多尺度目标并行检测 | ~48.1% | FPS≈25(V100),兼顾速度 |

RetinaNet(Focal Loss) | 解决 “正负样本不平衡”,减少背景误检 | ~40.8% | FPS≈10,速度较慢 |

DETR | 无锚框 + Transformer,直接建模目标关系 | ~42.0% | 对超密集(如 100 + 目标 / 图)鲁棒性强 |

选型结论:实时密集场景选YOLOv7-E6,非实时高精度场景选DETR。

二、3 大选型痛点解决方案

实际落地中,“精度与速度平衡”“硬件不兼容”“开源资源少” 是高频问题,需针对性突破。

1. 痛点 1:精度不够但速度不能降

解决方案:“轻量化算法 + 模型压缩” 组合,而非直接换高精度慢算法。

步骤 1:基础算法选轻量化版本(如 YOLOv5s→YOLOv8n,FPS 提升 30%,精度仅降 2%-3%)。

步骤 2:用 TensorRT/ONNX Runtime 量化模型(如 FP32→FP16/INT8),速度再提升 2-3 倍,精度损失<5%。

步骤 3:补充 “场景化微调”,用目标场景数据(如自家监控视频)微调模型,精度可回升 3%-4%。

2. 痛点 2:硬件资源有限(无高性能 GPU)

解决方案:优先选 “低计算量算法 + 硬件适配优化”。

嵌入式设备(如树莓派、Jetson Nano):选YOLOv5n(nano 版) 或 MobileNet-SSD,配合 OpenVINO(Intel 设备)/TensorRT(NVIDIA 设备)加速。

纯 CPU 环境:选PP-YOLOE-lite(百度飞桨),CPU 推理 FPS 可达 15+,比 YOLOv5s 快 50%。

极端低资源(如单片机):用Tiny-YOLOv3,模型体积<10MB,需牺牲部分精度(mAP@0.5≈25%)。

3. 痛点 3:开源资源少,调试难度大

解决方案:优先基于成熟框架选型,降低开发成本。

首选框架:MMDetection(支持 Faster R-CNN/Mask R-CNN 等两阶段算法,模块化易改)、YOLO 官方库(YOLOv5/v7/v8,文档全、社区问题多)。

避坑提醒:避免选小众算法(如早期 R-FCN、SSD 变体),开源代码少、 bug 难解决,后期维护成本高。

三、实用工具与资源包

为快速落地,整理 3 类核心资源,直接复用可节省 80% 调试时间。

1. 性能评估工具

精度评估:用COCO API计算 mAP、召回率、准确率,支持自定义目标类别。

速度测试:用torch.profiler(PyTorch)或TensorRT Profiler统计推理耗时,排除数据加载等非算法耗时干扰。

可视化工具:用Weights & Biases(W&B) 实时监控训练过程,对比不同算法的 loss、精度曲线。

2. 预训练模型库

直接加载预训练模型,可减少 70% 训练数据需求:

两阶段算法:MMDetection Model Zoo(https://mmdetection.readthedocs.io/zh_CN/latest/model_zoo.html)。

YOLO 系列:YOLO 官方 GitHub(https://github.com/ultralytics/ultralytics),含各尺寸预训练模型(n/s/m/l/x)。

小目标专用:遥感数据集预训练模型(如 DIOR、RSOD 数据集的 Faster R-CNN 预训练权重)。

3. 工程化优化手册

数据增强:小目标用 “Copy-Paste”,密集目标用 “Mosaic”,模糊场景用 “RandomBlur”。

锚框调整:若目标尺寸特殊(如细长型零件),用k-means 聚类重新计算锚框尺寸,提升匹配精度。

部署文档:Jetson 设备看《NVIDIA Jetson 部署 YOLOv8 指南》,Intel 设备看《OpenVINO 加速目标检测教程》。

需求留言:

需求留言: