一、边缘大模型网关:AI 服务的 "边缘神经中枢"

定义与定位

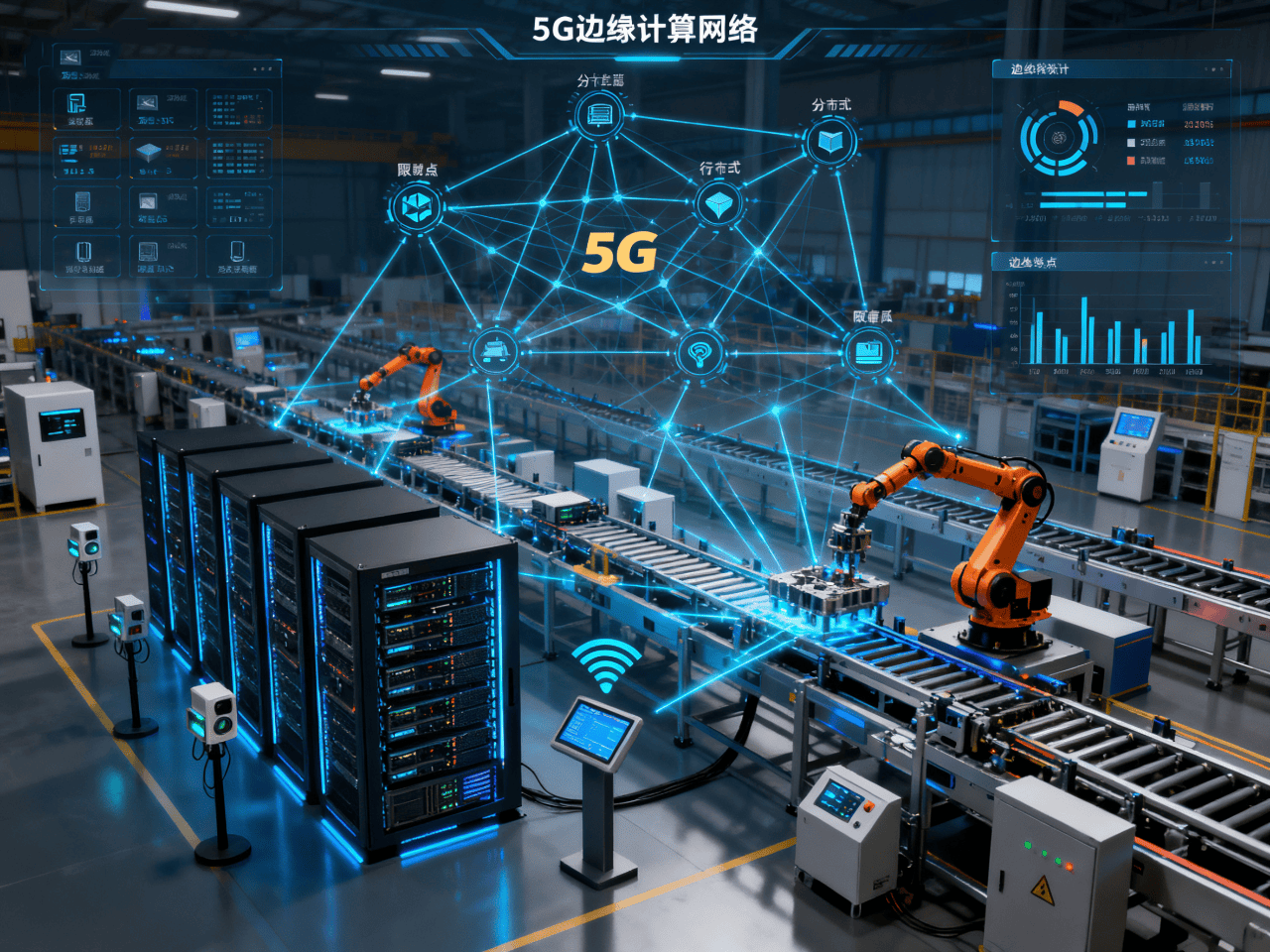

边缘大模型网关是部署在网络边缘节点的服务,允许用户通过单一 API 接口访问多家大模型提供商的模型与智能体;作为 "云 - 边 - 端" 架构的关键枢纽,将大模型能力下沉至离用户更近的位置,大幅降低延迟。

核心价值

统一接入:一个 API 对接 15 + 大模型厂商,屏蔽接口差异,降低集成成本;

边缘加速:利用全球分布的边缘节点实现就近调用,延迟降低 50%-90%;

智能调度:负载均衡 + 故障自动切换 + 请求重试,保障服务稳定性;

成本优化:语义缓存减少回源,节省 30%-70% 的 tokens 消耗;

二、API 统一调度:多模型管理的 "智能交通灯"

1. 标准化接口层:无缝对接的 "通用语言"

兼容 OpenAI API 规范:支持标准 SDK,无需重写代码即可接入新模型;

多协议支持:RESTful/gRPC/WebSocket 统一转换,适配不同应用场景;

请求签名统一:简化多模型密钥管理,支持动态 token 有效期设置;

2. 智能路由引擎:流量分配的 "决策大脑"

多维调度策略:

地理位置优先:将请求路由至最近边缘节点,延迟降低 40-60%;

负载感知:实时监控节点负载,动态调整流量分配,提升资源利用率;

模型优先级:支持 "主 - 备" 模型链,故障时自动切换 (如 DeepSeek→Claude→GPT-3.5);

成本控制:基于模型价格和性能,智能选择性价比最优的服务;

实现机制:

客户端请求 → 边缘接入层 → 负载均衡器 → 路由决策(地理位置+负载+优先级) → 目标模型 → 结果返回

3. 高级管控能力:服务质量的 "守护者"

熔断与限流:防止突发流量冲击,保障系统稳定性;

请求重试策略:设置最大重试次数和超时阈值,确保关键业务不中断;

流量镜像:支持 A/B 测试,评估不同模型性能差异;

全链路监控:实时追踪请求耗时、成功率、错误类型,支持性能调优;

三、10ms 级推理:极速响应的 "神经传导"

1. 模型轻量化:边缘运行的 "瘦身术"

核心技术:

量化压缩:FP32→INT8,模型体积缩小 75%,推理速度提升 3-8 倍,精度损失 < 1%;

知识蒸馏:从大模型提取知识到轻量级模型,参数量减少 80%,速度提升 3 倍;

神经网络架构搜索 (NAS):自动设计适合边缘的高效网络,减少 38% 乘法运算;

稀疏化剪枝:移除冗余连接,降低内存占用,提升计算效率;

2. 硬件加速:计算能力的 "涡轮增压"

硬件方案 | 性能提升 | 适用场景 |

GPU(NVIDIA Jetson) | 推理加速 5-10 倍,功耗 < 10W | 视觉处理、复杂 NLP |

NPU (如 ARM Ethos) | 4TOPS 算力,支持 10 亿参数模型 | 移动设备、IoT 终端 |

FPGA | 定制化加速,延迟降低至微秒级 | 特定算法、高频场景 |

专用 AI 芯片 (如含光 800) | 检测延迟从 120ms→35ms,算力需求 - 30% | 工业质检、智能监控 |

3. 系统级优化:全链路加速的 "润滑剂"

内存与计算优化:

内存池化:固定显存分配 + DMA 直通,减少上下文切换,延迟降低 20%;

算子融合:将多个操作合并为一个,减少内核调用,加速 2-5 倍;

混合精度计算:关键层用 FP32 保证精度,其他用 FP16/INT8 加速,平衡性能与精度;

边缘推理架构创新:

模型拆分 + 协同计算:

客户端(轻量预处理) → 边缘节点(核心推理) → 云端(复杂逻辑);

端侧算力需求降低 60%,响应时间提升 50%;

边缘缓存 + 流水线:

语义缓存:相同或相似请求直接返回结果,命中率可达 40%;

预热机制:提前加载常用模型,首 token 响应从 320ms→89ms;

批量推理:动态调整 batch size (1-16),QPS 提升 40%;

四、典型技术架构与实现案例

火山引擎边缘大模型网关:全球覆盖的 "极速通道"

架构亮点:

全球 2500 + 边缘节点,实现 10ms 级请求响应;弹性极速缓存 (EIC):通过 "以存代算" 和 GDR 零拷贝,推理延迟降至 20ms;支持 15 + 模型厂商,兼容 OpenAI API,3 步完成 DeepSeek 等模型接入。

性能数据:

豆包 1.5 模型:单轮对话延迟 < 20ms,支持万级并发;

DeepSeek 系列:平均响应时间从数百毫秒→几十毫秒,效率提升 80%;

网宿科技边缘 AI 网关:企业级智能 "中枢神经";

核心能力:

百模统一调度,支持动态负载均衡和故障转移;

"业务逻辑边缘化":将 AI 推理下沉至 CDN 节点,响应降至毫秒级;

MCP 服务:统一 API 协议转换,实现传统服务 AI 化;

落地案例:

某头部药企:通过边缘 AI 网关 + RAG 构建智能客服,响应时间 < 50ms,准确率 95%+;

传媒行业:内容创作效率提升 3 倍,敏感数据本地脱敏,隐私保护增强;

五、关键技术对比与选型指南

技术维度 | 边缘推理优化方案 | 性能提升 | 适用场景 |

模型优化 | 量化 + 蒸馏 + 剪枝组合 | 体积 - 90%,速度 + 5-10 倍 | 通用场景,尤其是资源受限设备 |

硬件加速 | NPU+GPU 异构计算 | 延迟 - 70%,功耗 - 50% | 高实时性、高吞吐场景 |

推理模式 | 云边协同 + 模型拆分 | 端侧负载 - 60%,响应 + 50% | 复杂模型,如大语言模型 |

缓存策略 | 语义缓存 + 预热机制 | 重复请求延迟 - 90% | 高频问答、知识库查询 |

六、落地挑战与未来趋势

当前挑战

模型适配:不同模型架构差异大,需针对性优化;

资源管理:边缘节点资源有限,需精细调度;

能耗控制:高性能推理与低功耗要求常冲突,需平衡;

未来趋势

模型分片部署:将大模型拆分为多个子模型分布在不同边缘节点,提升整体效率 (如 EdgeShard 技术提升 50% 吞吐量);

联邦学习 + 边缘推理:本地训练 + 全局聚合,保护数据隐私,提升模型适应性;

光计算 + AI:突破电子计算瓶颈,推理延迟降至微秒级,特别适合高速生产线质检;

总结:边缘 AI 的 "高速公路"

边缘大模型网关通过统一 API 调度和10ms 级推理两大核心能力,正在重塑 AI 应用格局。其技术实现依赖四大支柱:模型轻量化(瘦身)、硬件加速(增效)、智能调度(导流)和系统优化(提速)。

对企业而言,接入边缘大模型网关可获得三大价值:

开发效率提升:一个 API 接入所有主流大模型,开发周期缩短 70%;

用户体验飞跃:响应从 "卡顿级"(100ms+) 到 "无感级"(<50ms),转化率提升 20-40%;

成本结构优化:边缘缓存减少 30-70% 模型调用费用,硬件资源利用率提升 50%;

下一步建议:评估业务场景的延迟敏感性和调用频率,优先在高并发、低延迟场景(如智能客服、实时推荐)部署边缘大模型网关,逐步构建 "云 - 边 - 端" 协同的 AI 基础设施。

需求留言:

需求留言: