边缘计算模块凭借低延迟、高隐私、低成本、强可靠四大核心优势,正成为 AI 大模型从云端走向端侧、实现规模化落地的关键基础设施,驱动 "云 - 边 - 端" 协同智能新范式加速形成。

一、核心定位:从辅助到核心的转变

边缘计算模块是集成高性能处理器、AI 加速器、内存与存储的标准化硬件单元,作为 AI 大模型端侧部署的 "算力底座",它实现了三大关键转变:

转变维度 | 传统云端部署 | 边缘计算模块部署 |

算力架构 | 集中式云端处理 | 分布式边缘计算,数据 "就地处理" |

模型形态 | 完整大模型部署 | 轻量化模型 / 分层推理,适配资源约束 |

价值重心 | 计算效率优先 | 实时响应 + 数据隐私 + 成本优化并重 |

二、四大核心优势:解决端侧落地痛点

超低延迟,实时响应:数据无需长距离传输至云端,推理决策在本地完成,延迟从秒级降至毫秒级,满足自动驾驶、工业控制等对实时性要求极高的场景需求。

数据隐私,安全可控:实现 "数据不出本地" 的处理模式,避免敏感信息跨网络传输,满足医疗、金融、政务等关键领域的数据合规要求。

带宽优化,降本增效:减少 70% 以上的核心云数据传输量,大幅降低带宽成本,尤其适合大规模物联网部署场景。

离线运行,高可靠性:不依赖网络连接即可独立完成推理任务,确保在网络不稳定或无网络环境下 (如偏远工厂、野外设备) AI 服务持续可用。

三、关键能力:支撑大模型端侧部署的三大支柱

1. 高性能异构算力

主流边缘计算模块搭载NPU/GPU/TPU等 AI 专用加速器,提供30-100+TOPS的 INT8 算力,支持 FP16/FP32 混合精度计算;

如爱簿 E300 AI 计算模组 (50TOPS)、NVIDIA Jetson Orin Nano (67TOPS),可支持 32B 参数级大模型本地部署;

2. 模型适配与优化能力

模型压缩:通过量化、剪枝、知识蒸馏技术,将百亿参数模型压缩至适配边缘算力的规模;

分层推理:基座层 (如 Embedding 提取) 在云端,任务层 (如分类 / 生成) 在边缘,延迟降低 60%;

动态调度:支持根据实时负载自动调整模型精度 (FP32→FP16→INT8),平衡性能与功耗;

3. 端云协同架构

实现 "云端训练 - 边缘部署 - 数据回流 - 模型迭代" 的全链路闭环;

边缘大模型网关支持多模型提供商 API 统一接入,通过语义缓存减少回源,提升服务效率;

四、典型应用场景:赋能千行百业智能化

行业领域 | 核心应用 | 边缘计算模块价值 |

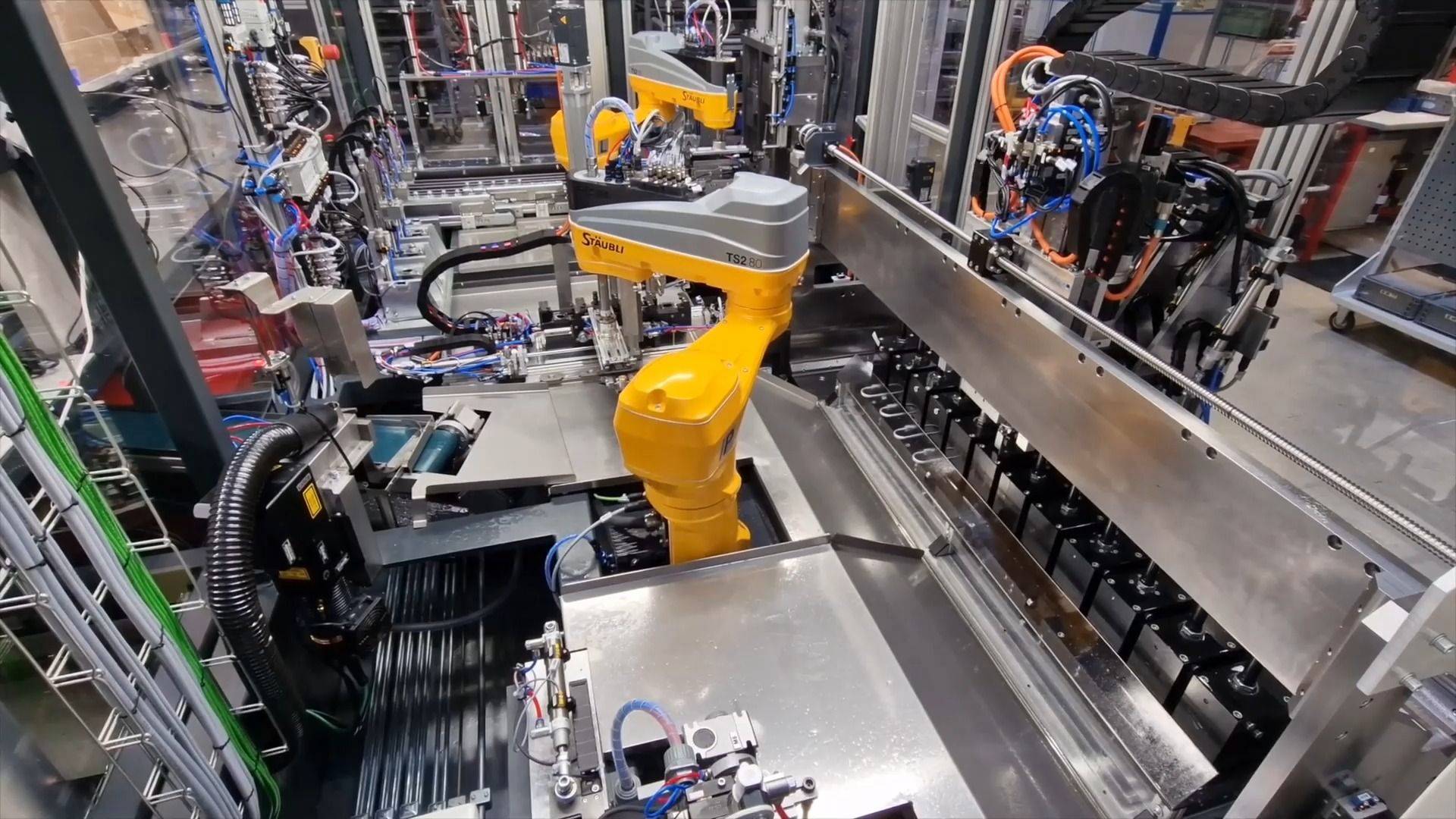

工业制造 | 设备预测性维护、视觉质检、柔性产线调度 | 毫秒级异常检测,降低停机损失 |

智能交通 | 自动驾驶辅助、交通信号优化、违章识别 | 本地实时决策,保障行驶安全 |

医疗健康 | 便携式诊断设备、手术机器人、病房监护 | 数据本地处理,符合医疗隐私法规 |

智慧城市 | 智能摄像头、环境监测、应急响应 | 降低云端压力,提升城市治理效率 |

能源电力 | 电网状态监测、新能源管理、故障预警 | 边缘节点自治,保障能源系统稳定 |

五、市场发展与技术趋势

1. 市场爆发式增长

IDC 预测:2027 年全球边缘服务器出货量将达1500 万台,支持 AI 功能的边缘服务器占比将从 2023 年的 10% 提升至50%;

边缘计算模块市场规模年增速超75%,成为 AI 硬件领域增长最快的赛道之一;

2. 技术演进方向

专用化设计:从 "模型压缩" 向 "为边缘设计" 的 SLM (Small Language Model) 转变,如 PhoneLM 项目;

存算一体:新型架构以 10 瓦功耗提供 100-160TOPS 算力,支持百亿级参数模型端侧运行;

系统级集成:大模型逐步下沉为操作系统级服务,边缘计算模块成为智能硬件的 "标配";

全栈优化:从芯片层到模型层再到应用层的全栈协同,如百度 ERNIE + 此芯 P1 处理器解决方案;

六、落地路径与挑战应对

1. 三步部署法

场景适配:分析应用对延迟、算力、功耗的具体需求;

模型选型:选择合适的轻量化模型 (如 Llama 2、Qwen、DeepSeek 的边缘版本) 或设计分层推理架构;

硬件匹配:根据模型规模和推理精度需求,选择对应算力等级的边缘计算模块;

2. 核心挑战与解决方案

挑战 | 解决方案 |

算力资源受限 | 模型量化 (INT4/INT8)、稀疏化处理、硬件加速单元优化 |

模型兼容性 | 采用 ONNX、TensorFlow Lite 等跨平台框架,统一模型接口 |

功耗与散热 | 动态电压频率调节 (DVFS)、低功耗芯片工艺 (6nm/5nm) |

管理复杂度 | 边缘智能平台 (如华为 IEF、百度智能云 ECS) 实现远程管理与运维 |

结语

边缘计算模块正推动 AI 大模型从实验室走向现实,从云端走向千行百业的终端设备。随着存算一体技术突破、专用边缘大模型兴起和端云协同生态完善,边缘计算模块将进一步巩固其核心载体地位,加速泛在智能时代的全面到来。

需求留言:

需求留言: