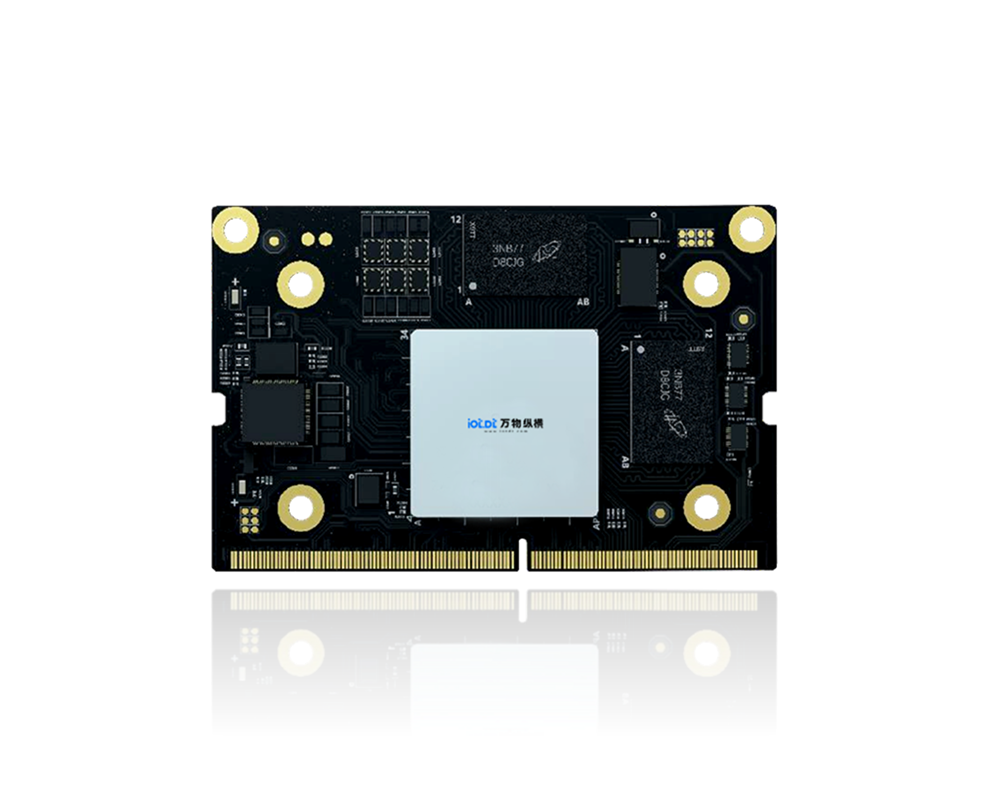

BM1688 核心板支持大模型私有化部署,尤其适合边缘计算场景下的轻量级大语言模型 (LLM) 与视觉语言模型 (VLM) 本地部署,能满足数据隐私与本地化推理需求。

一、核心支持能力

算力基础:INT8 算力达16 TOPS,FP16 为 4 TFLOPS,集成八核 ARM A53 CPU,支持 INT4/INT8/FP16/BF16/FP32 混合精度计算

模型适配范围:支持 Transformer 架构下的轻量级大模型,包括但不限于:

模型名称 | 参数规模 | 适配状态 |

Qwen1.5/Qwen2.5 | 1.8B/2B | 完美支持,含 VLM 版本 |

LLaMa2 | 7B | 支持 INT4 量化部署 |

ChatGLM3 | 6B | 支持 INT4/INT8 量化 |

Gemma | 2B | 官方验证支持 |

MiniCPM | 2.4B | 适配 SOPHON SDK 1.5.1+ |

部署工具链:依托算能官方LLM-TPU 项目与SOPHON SDK,通过 TPU-MLIR 编译器将模型转为 bmodel 格式,基于 tpu-runtime 推理引擎运行,支持 C++/Python 多语言开发

二、部署优势与限制

优势亮点

私有化保障:数据本地处理,规避云端传输隐私风险;

边缘适配:低功耗设计,适配工业控制、智能终端等嵌入式场景;

生态完善:兼容 PyTorch/TensorFlow 主流框架,支持 Docker 容器部署;

工具成熟:提供一站式开发包与模型编译、性能优化工具链;

部署限制

更适合7B 及以下参数的轻量级模型,不适合 13B + 大型模型(受内存与算力约束);

推荐INT4 量化以提升推理速度、降低内存占用(BM1688 对 INT4 优化良好);

SoC 模式需额外配置环境,建议搭配 8GB+ LPDDR4 内存;

三、快速部署路径

安装SOPHON SDK v1.5.1+(BM1688 专用版本);

用 TPU-MLIR 编译目标模型(支持 Hugging Face 主流模型);

基于 BMRT 或 tpu-runtime 编写推理代码,支持多轮对话等交互场景;

部署到 BM1688 核心板,通过 PCIe 或 SoC 模式运行;

四、应用场景建议

工业设备本地智能诊断(故障文本分析);

边缘网关 AI 助理(离线问答);

智能终端隐私计算(医疗 / 金融数据本地处理);

物联网设备语音交互(低延迟响应);

综上,BM1688 核心板是边缘侧大模型私有化部署的高性价比方案,尤其适合轻量化、低功耗、高隐私需求的场景,配合算能官方工具链可快速实现主流轻量级大模型的本地化部署。

需求留言:

需求留言: