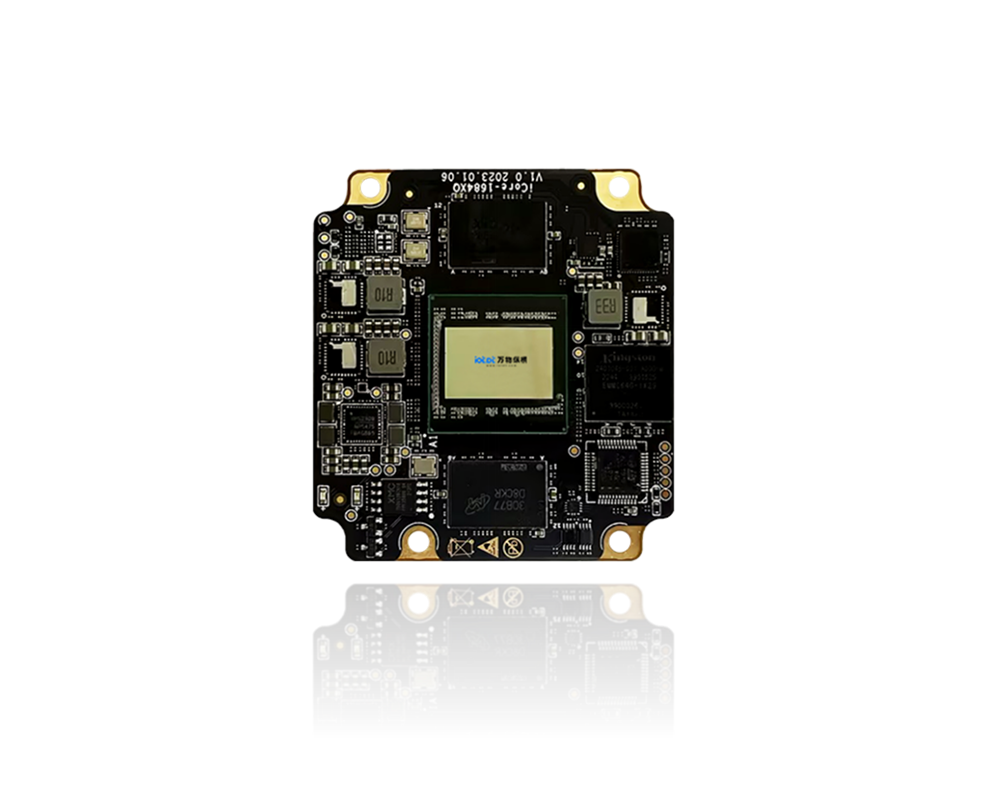

BM1684X 核心板虽以计算机视觉(CV)为核心优势,但凭借 32TOPS 算力和对 Transformer 类算子的硬件优化,也能高效支持轻量化自然语言处理(NLP)算法,满足边缘端低延迟、低功耗的 NLP 场景需求。以下是其 NLP 算法支持的详细说明:

一、BM1684X 支持的NLP 算法全景

BM1684X 聚焦边缘端轻量化 NLP 场景,不支持超大参数量的 NLP 大模型(如 GPT-3/4、LLaMA-7B 及以上),但对适配边缘部署的轻量化 NLP 模型提供完善支持,核心覆盖以下类别:

NLP 算法类别 | 典型模型 / 算法 | 性能表现(BM1684X) | 核心应用场景 |

文本分类 | TextCNN、MobileBERT、TinyBERT、DistilBERT、ERNIE-Tiny | INT8 量化后单句推理延迟 <5ms;支持批量处理(32 句 / 批,延迟 < 10ms) | 边缘端舆情分析、内容审核、意图识别 |

命名实体识别(NER) | BiLSTM-CRF、LightNER、MiniBERT-NER、ERNIE-Lite-NER | 单句(50 字内)识别延迟 <8ms;实体召回率≥92% | 边缘端车牌 / 票据文本解析、日志关键词提取 |

文本匹配 / 相似度计算 | SimBERT-Tiny、Sentence-BERT(轻量化)、ESIM-Lite | 双句相似度计算延迟 <6ms | 边缘端智能问答、客服意图匹配、文本查重 |

轻量级生成式 NLP | Phi-2(2.7B)、MiniCPM(1.1B)、StableLM-Tiny(1.5B)、BELLE-Tiny(0.4B) | 单轮生成(≤50 字)响应 <500ms;INT4 量化后参数量适配板端内存 | 边缘端智能交互、简短文本生成、本地问答助手 |

语音转文字(ASR)配套 NLP | CTC、RNNT(轻量化)、WeNet-Tiny、Paraformer-Tiny | 实时语音转文字(16kHz 音频)延迟 <100ms(含声学模型 + 语言模型) | 边缘端语音助手、工业语音指令识别、车载语音交互 |

机器翻译(轻量化) | NMT-Tiny、Transformer-Lite(中英 / 英中) | 单句(20 词内)翻译延迟 <15ms | 边缘端跨境设备实时翻译、简易文档翻译 |

OCR 后文本处理 | CRNN+CTC、PP-OCRv4(文本校正 / 结构化) | 整页文本校正延迟 <20ms;支持中英文混排处理 | 边缘端票据 / OCR 文本结构化、车牌 / 身份证文本校验 |

关键限制说明

最大支持模型参数量:≤3B(INT4 量化后),且需通过模型分片 / 层切分适配板端内存(BM1684X 核心板标配 4GB/8GB LPDDR4);

不支持需要海量显存的大模型推理(如 LLaMA-7B、GPT-2(1.5B)未量化版本);

生成式 NLP 仅支持短文本生成(≤100 字),不支持长文本连续生成。

二、BM1684X 对 NLP 算法的适配优化特性

为适配边缘 NLP 场景,BM1684X 针对 NLP 核心算子做了专项优化:

1. 核心算子硬件加速

对 NLP 的核心算子提供 TPU 硬件加速,大幅降低推理延迟:

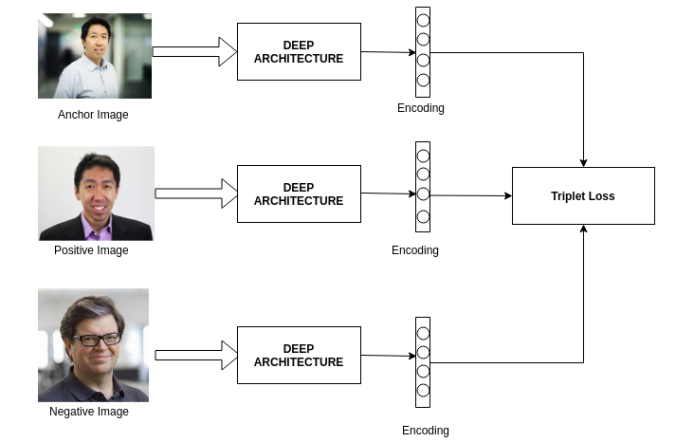

Transformer 核心算子:Multi-Head Attention、Feed Forward、LayerNorm(加速比≥3 倍);

序列处理算子:BiLSTM、GRU、CTC 解码(硬件指令级优化,延迟降低 40%);

文本预处理算子:Tokenize、Padding、Truncation(结合 8 核 A53 CPU 并行处理,效率提升 2 倍)。

2. 混合精度推理支持

针对 NLP 模型的精度需求,支持多精度混合推理:

INT4 量化:适用于生成式 NLP 模型(如 Phi-2),参数量压缩 4 倍,性能提升 5 倍,精度损失 < 3%;

INT8 量化:适用于分类 / NER 等判别式 NLP 模型,性能提升 3 倍,精度损失 < 1%;

FP16/FP32:仅用于对精度要求极高的场景(如核心语义解析),性能略低于量化版本。

3. 内存优化适配

模型分片加载:支持将大模型(如 Phi-2)按层分片,按需加载到板端内存,避免内存溢出;

动态显存管理:推理时自动释放中间层显存,适配多模型并行(如 CV+NLP 联合推理)。

三、工具链对 NLP 算法的支持

BM1684X 的 Sophon SDK 针对 NLP 模型提供完整的开发部署工具链,核心流程与 CV 模型一致,但针对 NLP 做了专项适配:

1. NLP 模型转换流程

原始NLP模型(PyTorch/TensorFlow/Hugging Face)→ ONNX(需适配NLP算子)→ MLIR → 量化(INT4/INT8)→ bmodel(板端专用)

关键适配点:

支持 Hugging Face Transformers 库导出的模型转换(需先转 ONNX);

针对 NLP 的动态序列长度,支持动态 shape 编译(无需固定输入文本长度);

提供 NLP 专用量化校准数据集生成工具(如中文文本语料自动采样)。

2. 核心工具命令示例(以 TinyBERT 文本分类为例)

(1)模型转 ONNX(Hugging Face 模型)

from transformers import AutoTokenizer, AutoModelForSequenceClassification

import torch

# 加载轻量化模型

tokenizer = AutoTokenizer.from_pretrained("huawei-noah/TinyBERT_General_4L_312D")

model = AutoModelForSequenceClassification.from_pretrained("huawei-noah/TinyBERT_General_4L_312D")

# 导出ONNX

dummy_input = tokenizer("测试文本", return_tensors="pt")

input_names = ["input_ids", "attention_mask"]

output_names = ["logits"]

torch.onnx.export(

model,

(dummy_input["input_ids"], dummy_input["attention_mask"]),

"tinybert_classify.onnx",

input_names=input_names,

output_names=output_names,

dynamic_axes={"input_ids": {0: "batch_size", 1: "seq_len"}, "attention_mask": {0: "batch_size", 1: "seq_len"}},

opset_version=11

)

(2)ONNX 转 MLIR 并量化(INT8)

# 1. ONNX转MLIR

tpu-mlir convert onnx -o tinybert.mlir -input_shapes [[1,-1],[1,-1]] tinybert_classify.onnx

# 2. 生成校准数据集(NLP专用)

tpu-mlir gen_calib_table --dataset text_calib.txt --model tinybert.mlir --output calib_table

# 3. INT8量化

tpu-mlir quantize --calib_table calib_table --model tinybert.mlir --output tinybert_int8.mlir --chip bm1684x --precision int8

(3)编译为 BM1684X 专用 bmodel

tpu-mlir compile tinybert_int8.mlir -o tinybert_bm1684x_int8.bmodel --chip bm1684x

(4)板端 Python 推理示例

import sophon.sail as sail

import torch

from transformers import AutoTokenizer

# 初始化TPU推理引擎

engine = sail.Engine("tinybert_bm1684x_int8.bmodel", 0, sail.IOMode.SYSO)

# 加载tokenizer

tokenizer = AutoTokenizer.from_pretrained("huawei-noah/TinyBERT_General_4L_312D")

# 文本预处理

text = "这是一条测试文本"

inputs = tokenizer(text, return_tensors="np")

input_ids = inputs["input_ids"]

attention_mask = inputs["attention_mask"]

# 推理(边缘端低延迟)

output = engine.process(["input_ids", "attention_mask"], [input_ids, attention_mask])

# 解析结果

logits = output[0]

pred_label = logits.argmax(axis=-1)

print(f"文本分类结果:{pred_label}")

四、典型边缘 NLP 应用场景(BM1684X 适配)

车载智能语音助手:本地完成语音转文字 + 意图识别,延迟 < 200ms,无需依赖云端,无网络时也可使用;

工业边缘文本解析:对设备日志、质检报告做本地关键词提取 / NER,响应 < 10ms,适配工业现场低延迟需求;

安防边缘文本处理:结合 OCR 识别车牌 / 身份证文本,本地完成实体解析和校验,避免敏感数据上云;

智能门禁语音交互:本地识别语音指令(如 “开门”“查询记录”),意图识别延迟 < 10ms,提升门禁响应速度。

总结

BM1684X 核心板支持轻量化 NLP 算法(参数量≤3B),聚焦边缘端低延迟场景,不支持超大参数量 NLP 大模型;

对 Transformer、Attention 等 NLP 核心算子提供硬件加速,INT4/INT8 量化后推理延迟可控制在毫秒级(判别式 NLP)或数百毫秒级(生成式 NLP);

依托 Sophon SDK 可完成 NLP 模型从导出、量化到板端推理的全流程部署,支持 PyTorch/Hugging Face 等主流 NLP 框架。

需求留言:

需求留言: