课堂行为分析系统是基于人工智能(AI)、计算机视觉(CV)、物联网(IoT)等技术,对课堂中学生的行为(如专注、走神、举手、互动)、教师教学行为(如板书、提问、走动)及课堂环境(如光线、声音)进行实时感知、分析与反馈的系统。其结构特点围绕 “数据采集 - 处理 - 分析 - 应用 - 隐私保护” 全流程设计,各层级既独立分工又协同联动,具体可拆解为以下六大核心特点:

一、多模态硬件采集层:全维度数据感知,支撑行为分析基础

硬件层是系统的 “感知器官”,核心目标是无死角、多维度采集课堂动态数据,避免单一数据源导致的分析偏差。其结构特点如下:

多设备协同采集

采用 “视觉 + 听觉 + 空间” 多模态设备组合,覆盖课堂全场景:

视觉设备:多机位摄像头(全景摄像头监控班级整体布局,特写摄像头聚焦学生面部表情 / 手部动作,避免遮挡盲区)、红外摄像头(适应低光环境,如多媒体课室遮光场景);

听觉设备:定向麦克风阵列(精准采集教师提问、学生发言、课堂噪音,过滤环境杂音,区分 “有效互动” 与 “混乱交谈”);

空间设备:座位传感器(辅助定位学生位置,结合视觉数据判断 “座位异动”,如擅自离座)、智能白板(同步教师板书 / 课件操作,关联 “教学行为与学生注意力关联分析”)。

实时性与低延迟

硬件采用边缘计算网关(如本地 AI 盒子),数据采集后优先在本地预处理(而非全部上传云端),减少网络传输延迟,确保课堂行为分析的 “实时性”(如学生举手后 1-2 秒内反馈给教师),满足课堂动态干预需求。

环境适应性强

设备设计适配不同教室场景:支持大中小班型(通过调整摄像头焦距 / 数量)、兼容传统教室与智慧教室(如与原有投影、电子屏设备对接),避免因环境差异导致的数据采集失效。

二、高效数据预处理层:清洗与特征提取,降低算法分析成本

原始采集数据(如模糊图像、嘈杂音频)存在大量噪声,预处理层是系统的 “数据过滤器”,核心作用是将原始数据转化为算法可识别的 “干净特征”,其结构特点如下:

多维度噪声过滤

图像端:通过图像去模糊、光照均衡、背景分割(如分离学生人体与教室桌椅),解决 “逆光人脸模糊”“背影遮挡” 等问题;

音频端:通过降噪算法(如谱减法)过滤空调声、走廊杂音,通过语音活动检测(VAD)区分 “人声” 与 “非人声”,提取有效语音片段。

跨模态数据对齐

统一视频(帧序列)、音频(时间戳)、空间传感器(位置数据)的时间轴,确保 “学生举手动作” 与 “同期发言声音”“座位位置” 精准匹配,避免因数据不同步导致的行为误判(如将 A 学生的动作匹配到 B 学生)。

轻量化特征提取

不直接传输高清原始视频 / 音频(减少带宽消耗),而是提取关键特征(如从图像中提取人脸关键点、人体姿态向量,从音频中提取语音频谱特征),仅将 “特征数据” 传入算法层,兼顾效率与分析精度。

三、智能算法分析层:多模型融合,平衡 “实时性” 与 “准确性”

算法层是系统的 “大脑”,负责将特征数据转化为 “可解读的课堂行为标签”(如 “专注”“走神”“举手”“小组讨论”),其结构特点如下:

多算法协同融合

单一算法难以覆盖复杂课堂行为,系统采用 “多模型组合” 策略:

行为识别:基于 OpenPose 的人体姿态识别(判断 “低头趴桌”“抬头看黑板”)+ 基于 CNN 的表情识别(判断 “专注”“困惑”“懈怠”);

互动识别:基于 NLP 的语音内容分析(判断学生发言是否 “回应教师问题”)+ 基于目标跟踪的群体行为分析(判断 “小组讨论是否有效参与”);

异常识别:基于时序模型(如 LSTM)的行为趋势分析(判断 “某学生持续 10 分钟走神” 等异常状态)。

实时性与准确性的动态平衡

课堂场景对 “实时反馈” 要求高(如教师需即时知道学生是否专注),算法层采用 “轻量化模型 + 本地推理” 为主、“高精度模型 + 云端协同” 为辅的架构:

本地端:部署轻量级模型(如 MobileNet 系列),实现 “毫秒级” 基础行为识别(如举手、趴桌);

云端端:对本地难以判断的复杂行为(如 “困惑表情”“低效讨论”),通过高精度模型(如 Transformer-based 模型)离线优化,并将优化参数反馈给本地模型,持续提升准确率。

自适应性与个性化调优

支持 “场景适配” 与 “用户定制”:

针对不同学段(小学 / 中学 / 大学)调整行为判断标准(如小学生 “短时转头” 可能是正常互动,大学生 “频繁转头” 更可能是走神);允许教师自定义行为标签(如将 “看课外书” 添加为 “异常行为”),通过少量标注数据微调模型,适配个性化教学需求。

四、场景化应用层:可视化与个性化反馈,服务教学决策

应用层是系统的 “价值输出端”,核心是将算法分析结果转化为教师、学生、管理者可直接使用的信息,其结构特点如下:

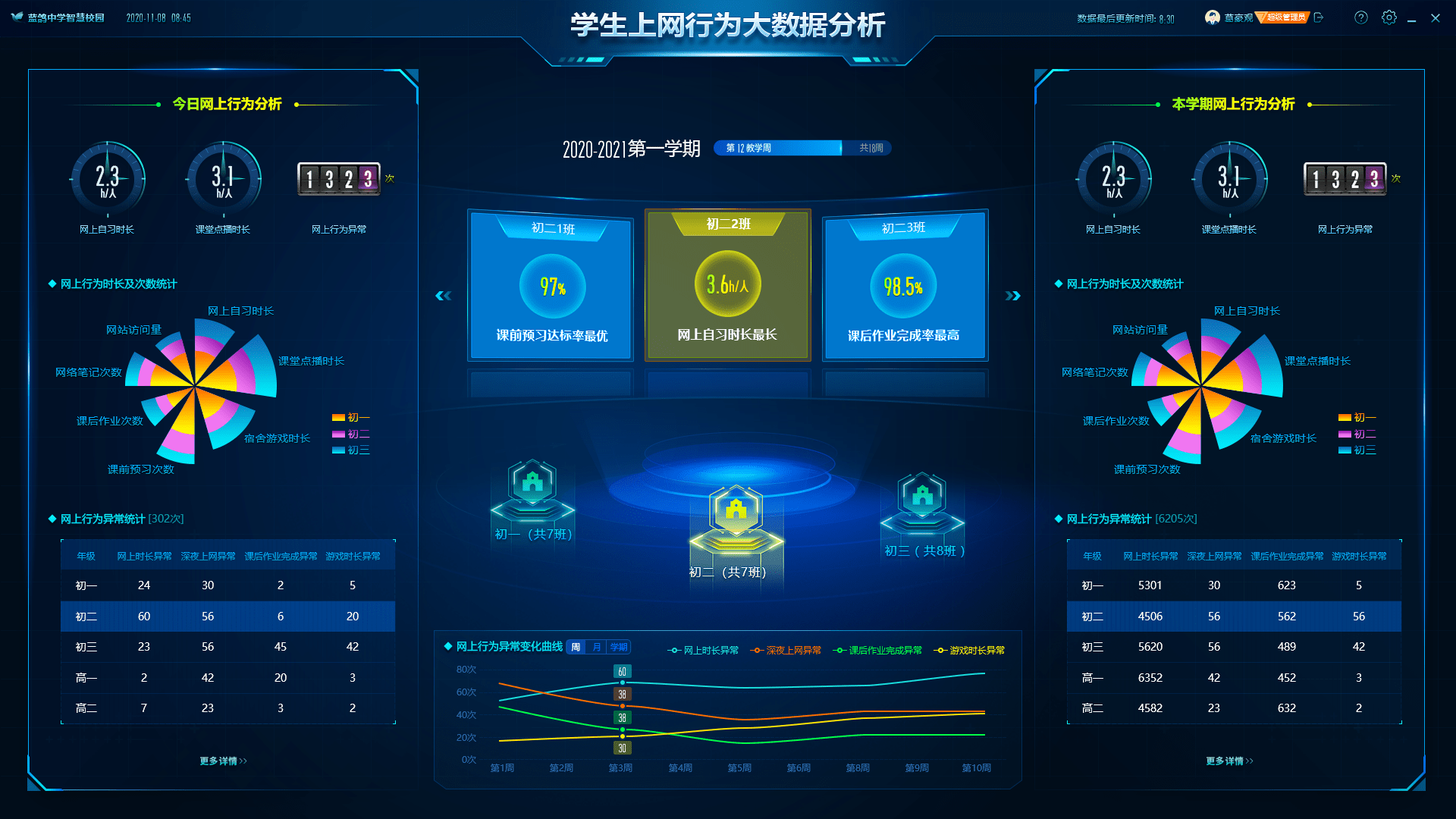

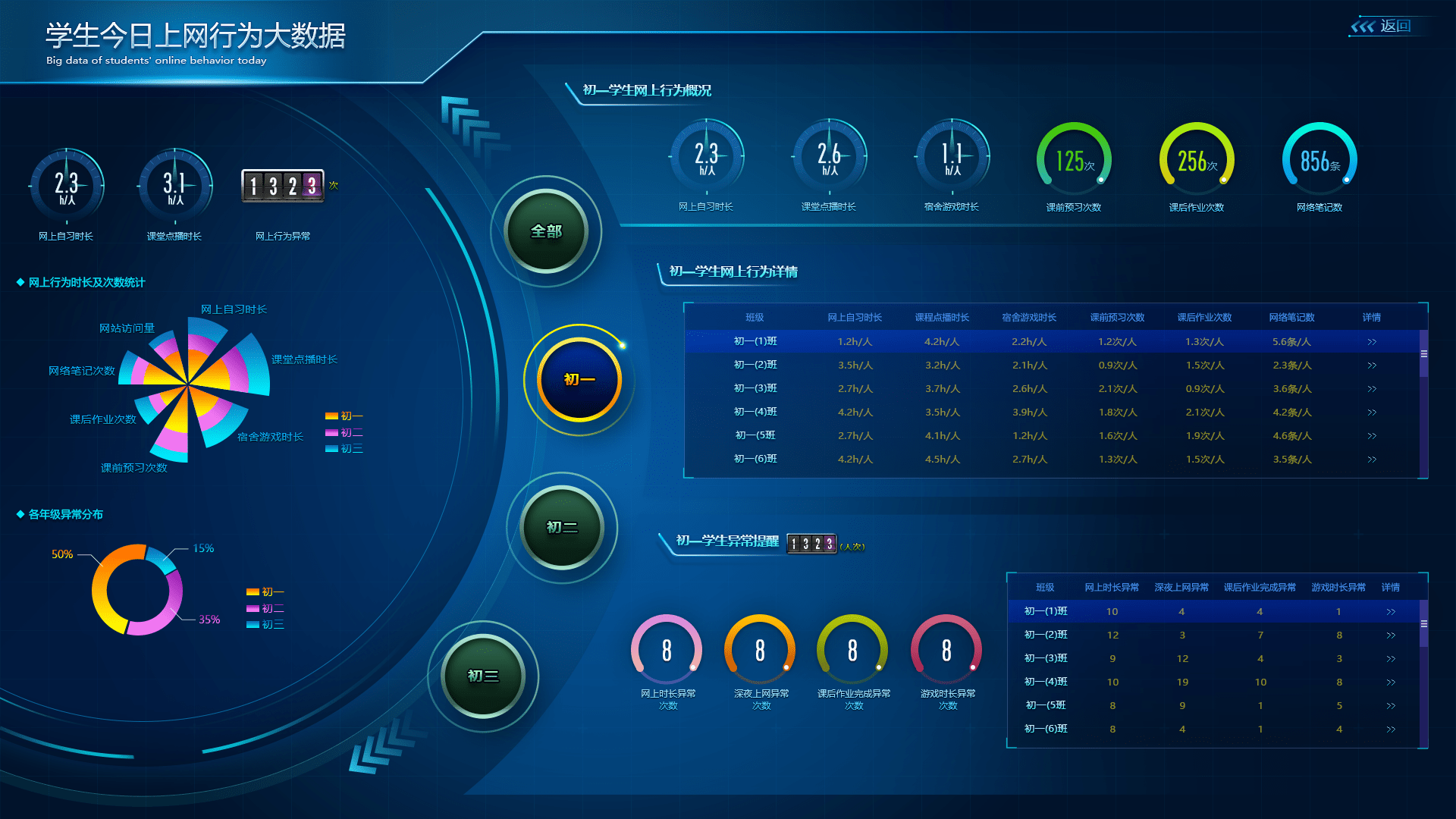

分层可视化呈现

针对不同用户角色设计差异化界面,避免信息过载:

教师端(实时仪表盘):以 “图表 + 预警” 形式展示核心数据 —— 班级整体专注率(折线图)、各学生行为状态(热力图,红色标记走神学生)、互动频次统计(柱状图),并对 “异常行为”(如 3 名学生同时趴桌)触发弹窗预警;

学生端(课后反馈):以 “时间轴 + 建议” 形式展示个人行为报告 —— 专注 / 走神时段分布(时间轴)、课堂互动参与度评分,搭配 “下次课堂可多关注黑板” 等个性化建议;

管理者端(宏观分析):以 “对比 + 趋势” 形式展示多班级 / 多课程数据 —— 不同班级的专注率对比、某课程的互动率周度趋势,辅助教学管理决策(如调整该课程的教学方法)。

交互式与可干预性

支持用户 “主动交互” 而非被动接收数据:

教师可点击 “走神学生” 头像,查看该学生的行为细节(如 “第 15 分钟开始低头,持续 5 分钟”),并记录 “干预措施”(如 “课堂提问提醒”),形成 “行为 - 干预 - 效果” 闭环;管理者可自定义分析维度(如 “按学科分析课堂互动率”“按教师分析教学行为”),生成定制化报表。

与教育系统深度兼容

不孤立存在,而是与现有教育生态对接:

数据互通:与教务系统对接,自动关联 “班级 - 学生 - 课程” 信息;与学情分析平台对接,将 “课堂行为数据” 与 “作业成绩、考试分数” 结合,分析 “行为与学业的关联性”(如 “专注率低的学生数学成绩平均低 15 分”);

教学辅助:与智慧黑板、在线教学平台联动,当系统检测到 “多数学生困惑” 时,自动提示教师 “放慢教学节奏” 或 “重复知识点”。

五、安全数据存储与隐私保护层:合规设计,规避数据风险

课堂数据涉及学生人脸、行为等敏感信息,隐私保护是系统的 “底线”,其结构特点如下:

数据全生命周期加密

传输端:采用 HTTPS/TLS 协议加密数据传输,避免中途被窃取;

存储端:采用国密算法(如 SM4)加密存储敏感数据,且 “行为标签” 与 “原始人脸图像” 分离存储(仅存 “专注 / 走神” 标签,不长期保存高清人脸);

销毁端:设置数据留存期限(如学期结束后自动删除非必要行为数据),避免数据冗余导致的隐私风险。

严格访问控制与权限管理

采用 “最小权限原则” 分配权限:

教师仅能查看自己所带班级的学生数据,且无法下载原始图像;管理者需经审批后才能查看多班级汇总数据,且操作留痕(可追溯谁查看了什么数据);学生仅能查看自己的个人数据,无法查看他人信息。

隐私增强技术(PET)应用

从技术源头减少隐私泄露风险:

采用 “联邦学习” 训练算法(各教室数据在本地训练,仅上传模型参数,不传输原始数据);

对采集的人脸图像进行 “脱敏处理”(如模糊处理、添加噪声),仅保留行为识别所需的特征点,不保留可识别个人身份的信息。

六、模块化与可扩展性:适配不同场景,支持后期升级

系统整体采用 “模块化架构” 设计,各层级(硬件、预处理、算法、应用)相互独立又通过标准化接口对接,其结构特点如下:

硬件模块化:支持 “按需选配” 设备(如普通教室仅装全景摄像头,重点教室加装特写摄像头与传感器),后期可单独升级某类设备(如将普通摄像头替换为 4K 摄像头),无需重构整个系统;

算法模块化:支持 “算法插件化”,可新增或替换某类行为的识别算法(如新增 “实验操作规范性识别” 算法,适配理科实验室场景);

应用模块化:支持 “功能定制”,可根据学校需求新增应用场景(如 “职业院校实训课堂行为分析”“在线直播课堂行为分析”),无需从零开发。

总结

课堂行为分析系统的结构特点围绕 “精准感知、高效分析、安全应用、灵活扩展” 四大目标展开,核心是通过 “多模态采集 - 智能算法 - 场景化反馈 - 隐私保护” 的全流程设计,既满足课堂实时干预的需求,又为教学优化、学情分析提供数据支撑,同时兼顾学生隐私与系统的可扩展性,最终服务于 “以学生为中心” 的智慧教育场景。

需求留言:

需求留言: