垃圾分类 AI 图像识别技术的核心是通过计算机视觉 + 人工智能算法,自动提取垃圾图像的视觉特征(如形状、颜色、纹理等),并匹配预定义的垃圾类别,最终实现精准分类。其完整流程可分为数据准备、模型设计与训练、推理部署、反馈迭代四大阶段,每个阶段包含具体的技术方法与实施细节,以下为详细拆解:

一、核心流程总览

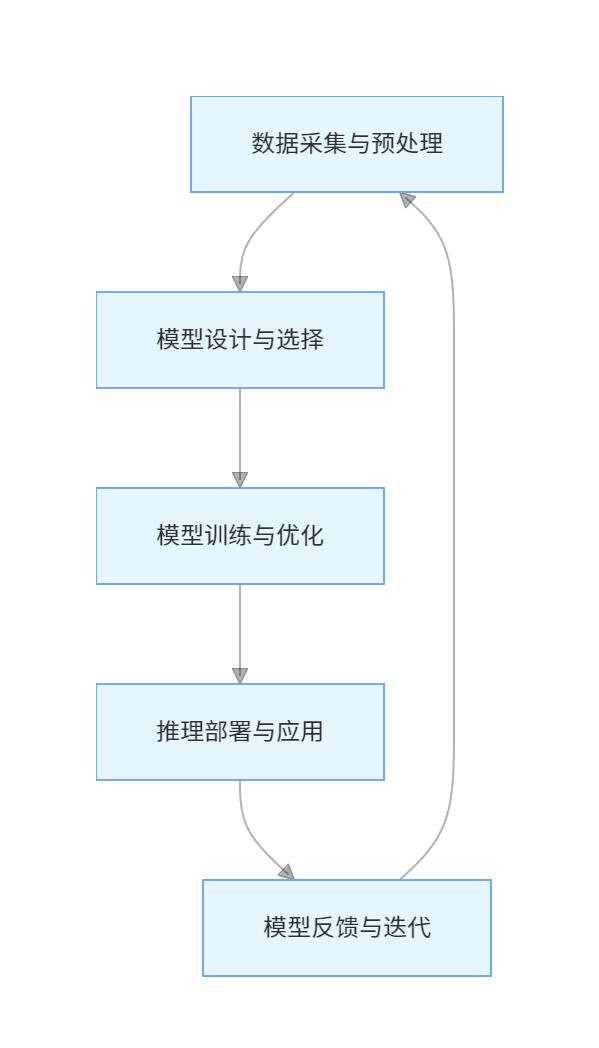

垃圾分类 AI 图像识别的本质是 “数据驱动模型学习特征→模型基于特征做决策”,整体流程如下:

graph TD

A[数据采集与预处理] --> B[模型设计与选择]

B --> C[模型训练与优化]

C --> D[推理部署与应用]

D --> E[模型反馈与迭代]

E --> A

二、各阶段详细方法与技术细节

阶段 1:数据采集与预处理(基础前提)

AI 模型的性能高度依赖数据质量与多样性,此阶段需解决 “数据从哪来、如何让数据适配模型” 的问题,分为 2 个子步骤:

1.1 数据采集:构建高质量数据集

数据集需覆盖垃圾分类的全场景、全类别、多变化,避免模型 “偏科”(如只认识干净的塑料瓶,不认识脏的塑料瓶)。

数据源类型:

真实场景采集:在家庭、社区、垃圾处理厂等场景,用摄像头拍摄不同状态的垃圾(如不同光照、角度、背景、污染程度),例如 “逆光下的易拉罐”“被食物污染的纸壳”。

公开数据集复用:基于现有开源数据集扩展,如:

TrashNet(经典数据集):包含 6 类垃圾(玻璃、纸、塑料、金属、硬纸板、杂类),共 2527 张图像;

国内数据集:如清华垃圾分类数据集(含 14 类垃圾)、阿里巴巴城市大脑垃圾分类数据集(含 200 + 类)。

合成数据补充:用 3D 建模生成虚拟垃圾图像(如不同形态的塑料袋),解决稀有垃圾样本不足的问题。

数据标注:给图像 “贴标签”

标注类型:根据任务需求选择:

图像分类标注:仅标注图像整体类别(如 “可回收物 - 塑料瓶”),工具如 LabelMe、VGG Image Annotator(VIA);

目标检测标注:标注垃圾的位置(用矩形框框选)+ 类别(如 “垃圾桶内的易拉罐”“纸巾”),工具如 LabelImg、YOLO 标注工具。

标注要求:准确率≥95%(标注错误会导致模型 “学错”),类别一致性(如不同标注员对 “快递盒” 统一标注为 “可回收物 - 硬纸板”)。

1.2 数据预处理:让数据 “适配模型”

原始图像存在噪声、尺寸不一等问题,需通过预处理标准化,保证模型输入一致性。

预处理步骤 | 核心目的 | 常用方法 |

图像清洗 | 去除无效样本 | 过滤模糊、过暗 / 过亮、标注错误的图像;删除重复样本(如同一角度的塑料瓶)。 |

图像增强 | 提升图像质量 | 调整亮度 / 对比度(应对逆光、阴影)、去噪(高斯滤波、中值滤波,去除图像杂点)。 |

尺寸归一化 | 统一模型输入尺寸 | 将图像 resize 为固定大小(如 224×224,匹配 CNN 模型输入要求)。 |

数据增强 | 扩大数据多样性(防过拟合) | 随机翻转(水平 / 垂直)、随机裁剪、旋转(±15°)、颜色抖动(调整色调);在 PyTorch/TensorFlow 中可通过transforms模块实现。 |

格式转换 | 适配模型输入格式 | 将图像从 RGB 格式转为张量(Tensor),并归一化像素值(如将 0-255 的像素值缩放到 0-1 或 - 1-1)。 |

阶段 2:模型设计与选择(核心算法)

根据垃圾分类的任务需求(分类 / 检测)、部署场景(边缘设备 / 云端) 选择合适的模型,主流分为 “传统机器学习” 和 “深度学习” 两类,目前以深度学习为主。

2.1 两类核心技术路径对比

技术路径 | 核心逻辑 | 适用场景 | 代表方法 |

传统机器学习 | 人工提取特征 + 分类器决策 | 简单垃圾(形态单一、特征明确) | 特征提取:HOG(方向梯度直方图)、SIFT(尺度不变特征变换);分类器:SVM(支持向量机)、随机森林、XGBoost。 |

深度学习(CNN) | 模型自动学习特征 + 端到端分类 / 检测 | 复杂场景(混合垃圾、形态多样) | 图像分类:LeNet、AlexNet、ResNet、MobileNet;目标检测:YOLO(实时检测)、Faster R-CNN(高精度检测)。 |

2.2 主流模型选择建议

场景 1:单垃圾图像分类(如用户单独扔一种垃圾)

优先用轻量级 CNN 或迁移学习模型:

若部署在边缘设备(如垃圾分类回收箱的嵌入式主板):选 MobileNet、EfficientNet-Lite(参数少、速度快,支持实时推理);

若数据量少(标注样本 < 1 万张):用迁移学习(如基于 ImageNet 预训练的 ResNet-50,冻结底层特征层,仅微调顶层分类层,减少训练成本)。

场景 2:多垃圾混合检测(如垃圾桶内有塑料瓶 + 纸巾 + 易拉罐)

优先用实时目标检测模型:

追求速度(如垃圾投放时实时识别):选 YOLOv5、YOLOv8(推理速度快,FPS 可达 30+,适合边缘设备);

追求高精度(如垃圾处理厂分拣):选 Faster R-CNN(准确率高,但速度较慢,适合云端部署)。

阶段 3:模型训练与优化(性能提升)

此阶段需通过 “迭代训练 + 指标评估”,让模型从 “不会分类” 到 “精准分类”,核心是解决 “过拟合”“准确率低”“推理慢” 等问题。

3.1 训练核心配置

训练环境:

硬件:GPU(如 NVIDIA Tesla V100、RTX 4090,加速模型计算);若数据量极大,可用 TPU(谷歌张量处理单元)。

框架:PyTorch(灵活性高,适合科研)、TensorFlow(部署友好,适合工程)。

关键参数设置:

损失函数:分类任务用交叉熵损失(衡量预测类别与真实类别的差距);目标检测用CIoU 损失(兼顾位置误差与类别误差)。

优化器:优先用Adam(自适应学习率,收敛快);若模型震荡,换 SGD + 动量(稳定性好)。

学习率:初始学习率设为 1e-4~1e-3(过高导致不收敛,过低导致训练慢);用 “学习率衰减”(如 StepLR,每 10 轮下降 10 倍)。

Batch Size:根据 GPU 内存调整(如 16、32,内存足够时越大越好,加速训练)。

3.2 模型评估与优化

评估指标:需同时关注 “准确率” 和 “实用性”,核心指标如下:

指标 | 含义(以可回收物分类为例) | 目标值 |

准确率(Acc) | 所有预测正确的样本占总样本的比例 | ≥90%(基础要求) |

召回率(Rec) | 实际为可回收物且被正确识别的比例(避免漏分) | ≥85%(减少可回收物浪费) |

精确率(Prec) | 预测为可回收物且实际为可回收物的比例(避免误分) | ≥85%(减少其他垃圾混入) |

推理速度(FPS) | 每秒可处理的图像数量(实时性要求) | ≥15 FPS(边缘设备) |

常见问题与解决方案:

问题 1:过拟合(训练集准确率高,验证集准确率低)

解决:增加数据增强(如 MixUp、CutMix)、添加 Dropout 层(随机 “关闭” 部分神经元,防止依赖特定特征)、用正则化(L1/L2 正则,限制参数过大)。

问题 2:某类垃圾识别准确率低(如 “纸巾” 与 “纸壳” 混淆)

解决:增加该类垃圾的样本量(尤其是难区分样本)、进行 “难例挖掘”(筛选模型预测错误的样本,单独标注并重新训练)、调整类别权重(在损失函数中给少数类更高权重,避免模型偏向多数类)。

问题 3:推理速度慢(边缘设备部署卡顿)

解决:模型压缩(量化:将 32 位浮点数转为 8 位整数,如 TensorRT 量化;剪枝:删除冗余的神经元和通道)、用轻量级模型(如 MobileNetV3、YOLOv8-nano)。

阶段 4:推理部署与应用(落地场景)

训练好的模型需部署到实际硬件中,实现 “实时采集图像→自动识别→分类执行” 的闭环,核心是兼顾 “实时性” 和 “稳定性”。

4.1 部署场景与硬件适配

部署场景 | 核心需求 | 推荐硬件 | 部署工具 / 框架 |

社区智能垃圾桶 | 低功耗、实时性、小型化 | 树莓派 4B、NVIDIA Jetson Nano(嵌入式 GPU) | TensorRT(优化推理速度)、ONNX Runtime(跨平台) |

垃圾处理厂分拣线 | 高吞吐、高精度 | 工业级 GPU(如 NVIDIA A10)、边缘服务器 | TensorFlow Serving、PyTorch TorchServe |

移动端 APP(如用户自查) | 轻量、低延迟 | 手机 CPU/GPU(如骁龙 8 Gen2) | TensorFlow Lite、PyTorch Mobile |

4.2 部署核心流程

模型格式转换:将训练好的模型(如 PyTorch 的.pth、TensorFlow 的.h5)转为部署友好格式:

边缘设备:ONNX(跨框架)、TensorRT(NVIDIA 硬件加速)、TFLite(移动端)。

图像实时采集:通过摄像头(USB 摄像头、工业相机)获取垃圾图像,用 OpenCV/PyAV 处理图像流(如帧提取、去畸变)。

推理与结果输出:

推理:将预处理后的图像输入模型,输出分类结果(如 “可回收物 - 塑料瓶,置信度 98%”)。

执行:若为智能垃圾桶,触发机械结构(如打开对应类别的垃圾桶门);若为 APP,在界面显示分类结果及回收建议。

阶段 5:模型反馈与迭代(持续优化)

实际场景中,模型会遇到 “未见过的垃圾类型”(如新型包装垃圾)或 “识别错误”,需通过反馈机制持续更新模型:

错误样本收集:在部署系统中添加 “反馈按钮”(如用户发现识别错误,点击 “纠错” 并标注正确类别),自动存储错误样本到数据库。

数据集更新:定期筛选错误样本,重新标注后加入训练集,扩充数据集多样性。

增量训练:用新数据集对原有模型进行 “增量训练”(仅更新顶层参数,避免从头训练),生成新版本模型。

模型更新部署:将优化后的模型重新部署到硬件,覆盖旧模型,实现性能持续提升。

三、关键挑战与应对策略

挑战 | 核心原因 | 应对策略 |

垃圾形态多样性 | 同一类垃圾形态差异大(如塑料袋折叠 / 展开) | 数据采集时覆盖多形态样本;用数据增强(如随机扭曲、缩放)模拟不同形态。 |

遮挡问题 | 垃圾相互遮挡(如易拉罐被纸巾覆盖) | 训练时加入遮挡样本;用目标检测模型(如 YOLOv8)的 “遮挡鲁棒性” 优化。 |

跨地区分类标准差异 | 不同城市分类标准不同(如 “厨余垃圾” vs “湿垃圾”) | 模型设计时支持 “类别配置文件”(通过修改配置文件切换分类标准,无需重新训练)。 |

边缘设备算力限制 | 嵌入式设备内存 / 算力有限 | 用模型压缩(量化、剪枝)+ 轻量级模型;采用 “边缘 - 云端协同”(简单任务边缘处理,复杂任务云端处理)。 |

四、总结

垃圾分类 AI 图像识别是 “数据 + 模型 + 部署” 的系统工程,核心流程可概括为:“数据打底→模型学习→部署落地→反馈迭代”。实际应用中,需根据场景需求(如实时性、精度、硬件成本)选择合适的技术方案,尤其要重视数据质量和模型轻量化,才能实现 “精准、高效、低成本” 的垃圾分类落地。

需求留言:

需求留言: